Auch wenn es in den letzten Monaten nicht so aussieht, der Kampf um den Suchmaschinenmarkt ist noch lange nicht beendet und scheint langsam in die nächste Runde zu gehen. Das Web zu indizieren, durchsuchen und dem User in sekundenschnelle zu präsentieren kann mittlerweile jeder. Was jetzt zählt ist eigener Content und neue Ranking-Methoden - und davon hat Google jede Menge...

Eigener Content

Google hat schon sehr früh verstanden dass es nicht ausreichen wird lediglich öffentlichen Content stur nach einer Übereinstimmung zu durchsuchen und zu präsentieren. Durch all die Hosting-Dienste die in den letzten Jahren gestartet worden sind. Angefangen von den

Mails über die

Termine und die

eigenen Dateien bis hin zu den

Dokumenten kann Google mittlerweile so gut wie alles durchsuchen und dem User eine komplett personalisierter Suchmaschine anbieten die sich nicht auf das Internet beschränkt - theoretisch.

Eigenen Content zu bieten den die anderen Suchmaschinen nicht haben wird immer wichtiger, und Google hat davon - genau wie die Konkurrenz - jede Menge. Yahoo! hat es damals vorgemacht und seinen Usern kostenlos alle möglichen Dienste angeboten, aber leider hat Yahoo! zu spät das Potenzial dieser Datenmassen erkannt und hinkt bis heute damit hinterher die Daten zu verwenden und damit Geld zu verdienen.

Andere Suchmaschinen wie z.B. MSN haben den Trend komplett verschlafen und bieten erst jetzt nach und nach Hosting-Dienste an, ask.com lässt dieses Thema sogar bis heute außer acht - wird damit aber sicherlich demnächst auch anfangen.

Ich denke Google ist mit seinem Informationsnetzwerk sehr gut aufgestellt und hat über all seine User soviele Informationen die aufbereitet und durchsuchbar gemacht werden können dass der

Marktanteil auch in den nächsten Jahren so gut wie gesichert ist und auch weiterhin kräftig steigen wird.

Ranking-Methoden

Genauso wichtig wie der Inhalt der Suchergebnisse ist natürlich auch das Ranking, sprich die Reihenfolge, der Suchergebnisse. Damals hatte Google das Ranking mit seinem

PageRank revolutioniert und hat die Informationsfindung im Web stark verbessert. Im Grunde basiert das ganze System auf der Annahme dass viel verlinkte Webseiten wahrscheinlich wertvollen Content beinhalten und damit weit oben in den Suchergebnissen stehen müssen.

(Leider) wurde auch dieses System mittlerweile von allen Suchmaschinen kopiert. Zwar wurde die Perfektion von Google noch nicht erreicht, aber bis dahin ist es nur noch ein kleiner Schritt. Außerdem ist das System stark Spam-anfällig und kann durch einfache Verlinkungsnetzwerke ausgetrickst werden. Grund genug also um ein völlig neues System zu entwickeln dass niemand so einfach überlisten und vorallem die Konkurrenz nicht kopieren kann.

Sobald der User die Suchergebnisseite verlässt hat die Suchmaschine keine Möglichkeit mehr zu verfolgen wie lange sich der User auf der Seite aufhält und ob sie ihm jetzt weitergeholfen hat oder nicht. Bei Google ist das anders, auf so gut wie jeder Webseite ist irgendein Google-Tool eingebunden mit dem theoretisch durch Auswertung aller Daten und IP-Vergleich die Surf-Session des Users weiterverfolgt werden kann - und sei es nur durch die Einbindung von Suchergebnissen, YouTube-Videos oder durch AdSense-Banner.

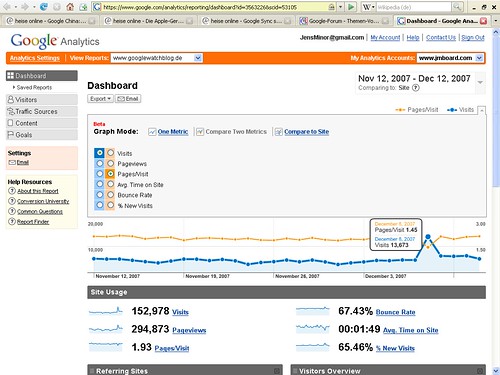

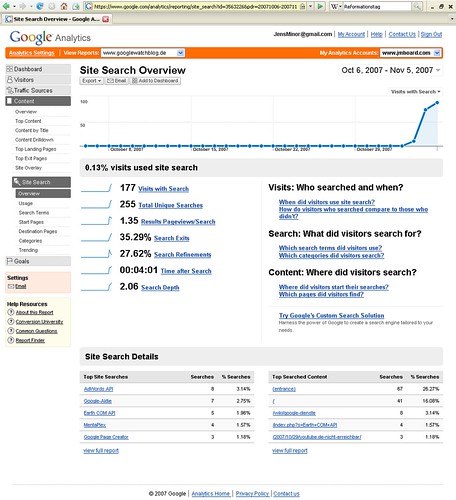

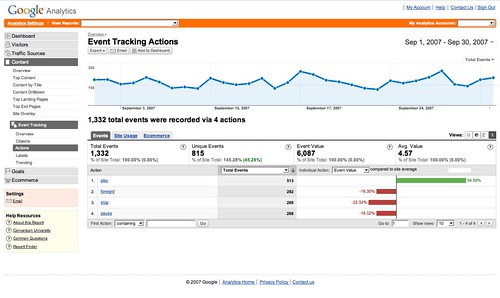

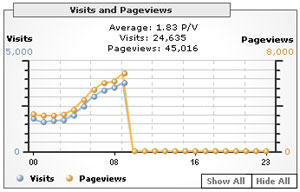

Doch auf die Auswertung dieser Daten ist Google mittlerweile garnicht mehr angewiesen. Viele Webseiten setzen mittlerweile dass Analysetool

Google Analytics ein - dank des kostenlosen Angebots und der Vielfalt der Statistiken und Funktionen ist es weit verbreitet und hilft stark bei der Datensammlung. Durch Analytics sammelt Google mehr Daten über Webseiten als die Webmaster selbst und kann die Suchergebnisse damit natürlich stark verbessern.

Google weiß genau wieviele User welche Webseite tatsächlich besuchen, wie lange sie sich dort aufhalten, wohin sie klicken und vieles mehr. Diese Daten können natürlich wunderbar in das Ranking der Seiten einfließen. Eine Seite mit starker Verlinkung auf der sich die User nur wenige Sekunden aufhalten kann demzufolge nicht so stark sein als eine Webseite mit wenige Verlinkung aber dafür vielen Besuchern die sich lange aufhalten. Wertvolle Daten die keine andere Suchmaschine hat.

Dass Google derzeit Analytics ein

Redesign verpasst ist kein Wunder. Das ganze Tool soll noch attraktiver und einfacher zu bedienen werden damit noch mehr User das Tool einsetzen und Google so immer mehr Daten über immer mehr Webseiten sammeln kann - eine Hand wäscht die andere.

Web History

Sollte es dann tatsächlich eines Tages noch Webseiten geben die Analytics nicht einsetzen, so werden die Daten auf einem anderem Wege gesammelt - noch dazu perfekt personalisiert. Durch die

Web History erfährt Google auch das komplette Surfverhalten all seiner User wenn sie außerhalb des Analytics-Netzes surfen. Ein besseres Tool zum Aufbau von Nutzer- und Surf-Profilen kann man sich im Grunde garnicht wünschen.

Mithilfe des Surfverlaufs erhält Google auch Daten die mit Analytics nicht gesammelt werden können. Klickt ein User bspw. auf einer Analytics-Seite einen externen Link an erfährt Analytics das - weiß dann aber nicht wie die Surf-Session weiter verläuft. Hier kommt der Webverlauf ins Spiel der die Tour durch die Webseite so lange wieder aufzeichnet bis man wieder auf einer Analytics-Seite angekommen ist.

Die beiden Tools greifen also perfekt ineinander und können so gut wie jeden User erfassen, ob er will oder nicht. Die Frage ist nur was passieren wird wenn Google diese Daten eines Tages - und der ist sicher nicht weit - tatsächlich zusammenfassen und für seine Zwecke nutzen wird. Da kommt eine sehr sehr harte Zeit auf die Datenschützer zu...

--

Ich denke es gibt zur Zeit keine Firma die soviele Daten über den weltweiten Internet-Traffic, das User-Verhalten und die Beliebtheit der Webseiten sammeln kann als Google. Diese ganzen Daten zusammengefasst, mit einem Schuss Personalisierung gewürzt, ergibt die perfekte Suchmaschine - und die wird

garantiert demnächst kommen. Und die Konkurrenz schaut in die Röhre...

»

Inspirationsartikel: The knowledge and the Power

[thx to:

Stefan2904]

+

+