Suchergebnisse für Sitemaps

Und das neue:

Und das neue:

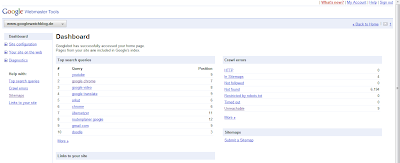

» Neues Design

» Neues Design

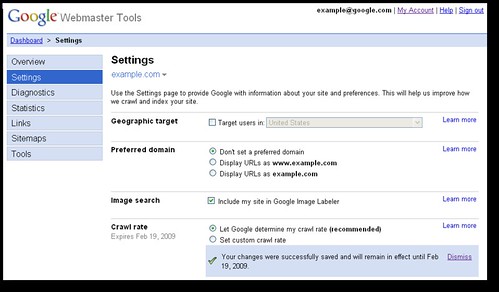

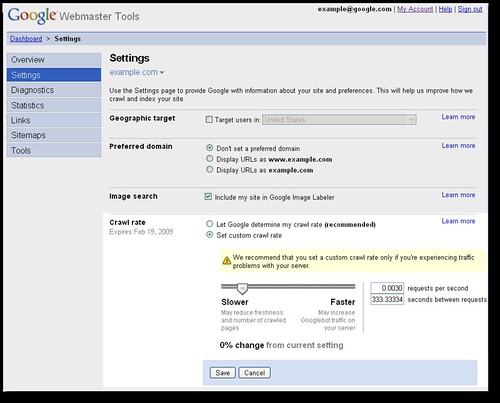

In der Oberfläche gibt es jetzt den neuen Menüpunkt "Settings" in dem sich auf einer Seite alle Einstellungsmöglichkeiten die die Webmaster Tools bieten befinden. Dort kann jetzt das Land, die Darstellung der URL, das einbinden der Fotos in den Google Image Labeler und die Crawling-Rate der Webseite eingestellt werden. In all den anderen Menüpunkten sind diese Einstellungen jetzt verschwunden. Obwohl die Änderungen mittlerweile seit 2 Tagen abgeschlossen sein sollten, funktioniert das ganze zumindest bei mir noch überhaupt nicht. Die Settings-Page ist bei mir bis auf die Landeseinstellung komplett leer, ich kann also keine Einstellungen mehr für den GWB vornehmen. Auch in den anderen Seiten sind die Einstellungen verschwunden. Daher kann ich leider keine eigenen Screenshots liefern und das Crawling-Update testen: Crawling-Einstellungen verbessert

Bisher hatte man 3 Einstellungsmöglichkeiten um die Crawling-Geschwindigkeit des GoogleBots anzupassen: Low (Wenige Besuche), Max (Viele Besuche) und das automatische anpassen - was immer noch die Standardauswahl ist und auf einer Reihe von Parametern basiert wie z.B. Aktualität der Seite und Ladegeschwindigkeit. Jetzt kann man die Crawling-Rate stufenlos über einen Regler einstellen. Außerdem kann die Anzahl der maximalen Server-Anfragen pro Sekunde und die Zeit die zwischen 2 Abfragen liegen muss eingestellt werden. Durch ausprobieren bekommt man im Laufe der Zeit sicherlich einen guten Wert hin mit dem die Seite im Index Aktuell bleibt und den Server dennoch nicht in die Knie zwingt. -- Bisher hat man es zwar noch nicht angekündigt, aber demnächst dürfte dann wohl auch das aufräumen der Statistiken und deren verbesserte Darstellung anstehen. Im Grunde bräuchte man ja auch nur die beiden Menüpunkte "Settings" und "Statistics". Bin gespannt was da noch so kommt. Eine Integration in Analytics wäre wohl am besten, obwohl das sicherlich einige Probleme mit sich bringt... » One place for changing your site's settings » More control of Googlebot's crawl rate [Blogoscoped-Forum]

Bisher waren die Seiten von Google Profile nur eher sporadisch von Suchmaschinen indiziert worden - einfach aus dem Grund das sie nirgendwo öffentlich verlinkt sind, es sei denn der User verlinkt sich selbst irgendwo. In einigen Stunden wird sich das allerdings ändern, denn Google teilt allen Suchmaschinen nun per Sitemap die URLs von 150.000 öffentlichen Profilen mit.

Seit wenigen Stunden findet sich in Googles robots.txt ein Link zu einer Profiles Sitemap in dem wiederum 30 Textdateien verlinkt sind. Jeder dieser Textdateien enthält 5.000 URLs die allesamt auf gut gefüllte Profile verlinken. Es ist also nur noch eine Frage von Stunden bis die großen Suchmaschinen die Profile indiziert und gelistet haben.

Hervorgegangen ist das Google Profile damals aus Google Shared Stuff und wurde seitdem kontinuierlich erweitert und in verschiedene Dienste wie Maps, Reader und Knol integriert. Wirklich selbstständig war der Dienst bisher aber nicht, das wird sich nun ändern und das Profile wird quasi die Web-Visitenkarte hosted by Google.

Da die Visitenkarten direkt auf google.com gehostet werden, dürfte diese bei sehr vielen Namen jetzt direkt auf Platz 1 in den Suchergebnissen stehen. Ich denke Google hätte einige Wochen vor dieser Öffnung eine Möglichkeit anbieten sollen das Profil aus Suchmaschinen entfernen zu dürfen bzw. gar nicht erst listen lassen zu dürfen. Was haltet ihr von dieser direkten Verlinkung der Profile?

P.S. Es scheinen 150.000 Profile verlinkt zu sein. Hat jemand eine Ahnung ob diese Zahl realistisch ist oder ob es noch mehr Profile gibt? Ist eure Seite gelistet?

» Profile-Sitemaps

[ZDNet-Blog]

Bisher waren die Seiten von Google Profile nur eher sporadisch von Suchmaschinen indiziert worden - einfach aus dem Grund das sie nirgendwo öffentlich verlinkt sind, es sei denn der User verlinkt sich selbst irgendwo. In einigen Stunden wird sich das allerdings ändern, denn Google teilt allen Suchmaschinen nun per Sitemap die URLs von 150.000 öffentlichen Profilen mit.

Seit wenigen Stunden findet sich in Googles robots.txt ein Link zu einer Profiles Sitemap in dem wiederum 30 Textdateien verlinkt sind. Jeder dieser Textdateien enthält 5.000 URLs die allesamt auf gut gefüllte Profile verlinken. Es ist also nur noch eine Frage von Stunden bis die großen Suchmaschinen die Profile indiziert und gelistet haben.

Hervorgegangen ist das Google Profile damals aus Google Shared Stuff und wurde seitdem kontinuierlich erweitert und in verschiedene Dienste wie Maps, Reader und Knol integriert. Wirklich selbstständig war der Dienst bisher aber nicht, das wird sich nun ändern und das Profile wird quasi die Web-Visitenkarte hosted by Google.

Da die Visitenkarten direkt auf google.com gehostet werden, dürfte diese bei sehr vielen Namen jetzt direkt auf Platz 1 in den Suchergebnissen stehen. Ich denke Google hätte einige Wochen vor dieser Öffnung eine Möglichkeit anbieten sollen das Profil aus Suchmaschinen entfernen zu dürfen bzw. gar nicht erst listen lassen zu dürfen. Was haltet ihr von dieser direkten Verlinkung der Profile?

P.S. Es scheinen 150.000 Profile verlinkt zu sein. Hat jemand eine Ahnung ob diese Zahl realistisch ist oder ob es noch mehr Profile gibt? Ist eure Seite gelistet?

» Profile-Sitemaps

[ZDNet-Blog]

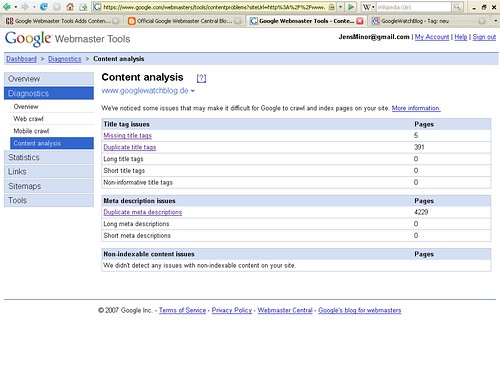

Der Titel und die Beschreibung einer Seite sind zwar heute für das Crawling und Ranking einer Seite vollkommen unwichtig geworden, aber zumindest werden diese Angaben auch heute noch in den meisten Suchmaschinen genutzt - der Titel auf jeden Fall und die Meta-Description in einigen Ausnahmefällen. Doppelte Titel sollten deswegen vermieden werden, da eine Seite mit komplett anderem Inhalt so in den Suchergebnisse vom User als gleiche Seite erkannt und womöglich garnicht angeklickt wird. Wie man auf dem Screenshot sieht strotzt der GWB _theoretisch_ nur so vor Fehlern. Zwar wird hier bei der Anzeige eines Tags oder einer Kategorie der Titel "GoogleWatchBlog - Tag: update" verwendet, aber auch auf den folgenden Seite der Tag-Anzeige wird dieser verwendet - obwohl es sich um eine völlig andere Seite handelt. Korrekt wäre jetzt also "GoogleWatchBlog - Tag: update - Seite X". Für mich sinnlos, von daher können diese Fehler ignoriert werden. Der nächste Fehler ist merkwürdig: Google kreidet es als eventuellen Fehler an dass 4229 Seiten die gleiche META-Description beinhalten. In den meisten Fällen wird in dieser Description aber nicht der Inhalt der gerade angezeigten Seite sondern eine allgemein Beschreibung der kompletten Homepage gegeben. Von daher ist es völlig normal dass sich diese Angabe nie ändert und sollte nicht als Fehler angekreidet werden. -- Ich konnte mit diesen Fehlern jetzt zwar nichts anfangen, aber anderen Webmaster kann dies vielleicht helfen auf einen Blick zu sehen welche Seiten noch keinen Aussagekräftigen Titel besitzen - SEO ist eben alles. Was mir jetzt immer noch fehlt ist ein Angebot dass die Sitemaps und Google Analytics verbindet. Auf diese Weise könnten eigentlich unendlich viele Analysen aufgestellt werden die dem Webmaster wirklich weiterhelfen. » Ankündigung im Webmaster Central Blog [Google Blogoscoped]

Googles Niederlassung in Kirkland hat gestern ihren 3. Geburtstag gefeiert und aus Mountain View einen - hmm, ja doch recht "interessanten" - Kuchen spendiert bekommen :-D Die Googler in Kirkland sind unter anderem für Google Talk, Google Pack, Sitemaps, Site Optimizer, Toolbar for Firefox, die Google Maps und auch für die Werbung in den Suchergebnissen sowie die Videosuche verantwortlich. Jede Menge Arbeit also... Und da es gerade so gut zu laufen scheint wird Kirkland zur Zeit kräftig erweitert. » Geburtstagsfeier im Google-Blog