Google Maps 3D: Das ist die innovative Routenplanung – Entwickler erklären aufwendige Technologie (Videos)

Auf der Kartenplattform Google Maps befinden sich neben unzähligen Informationen zu allen Orten auf dieser Welt auch eine gigantische Menge an Bildmaterial – von Satellitenbildern über Streetview bis hin zu den Nutzerfotos. Vor einiger Zeit hat Google Maps aus der Kombination dieser Bilddaten und Vermessungen sowie der Mithilfe von Künstlicher Intelligenz das Produkt Google Maps Immersive View gestartet. In einem langen Blogbeitrag verraten die Ingenieure, welcher Aufwand dahintersteckt und wie datenintensiv die Entwicklung war.

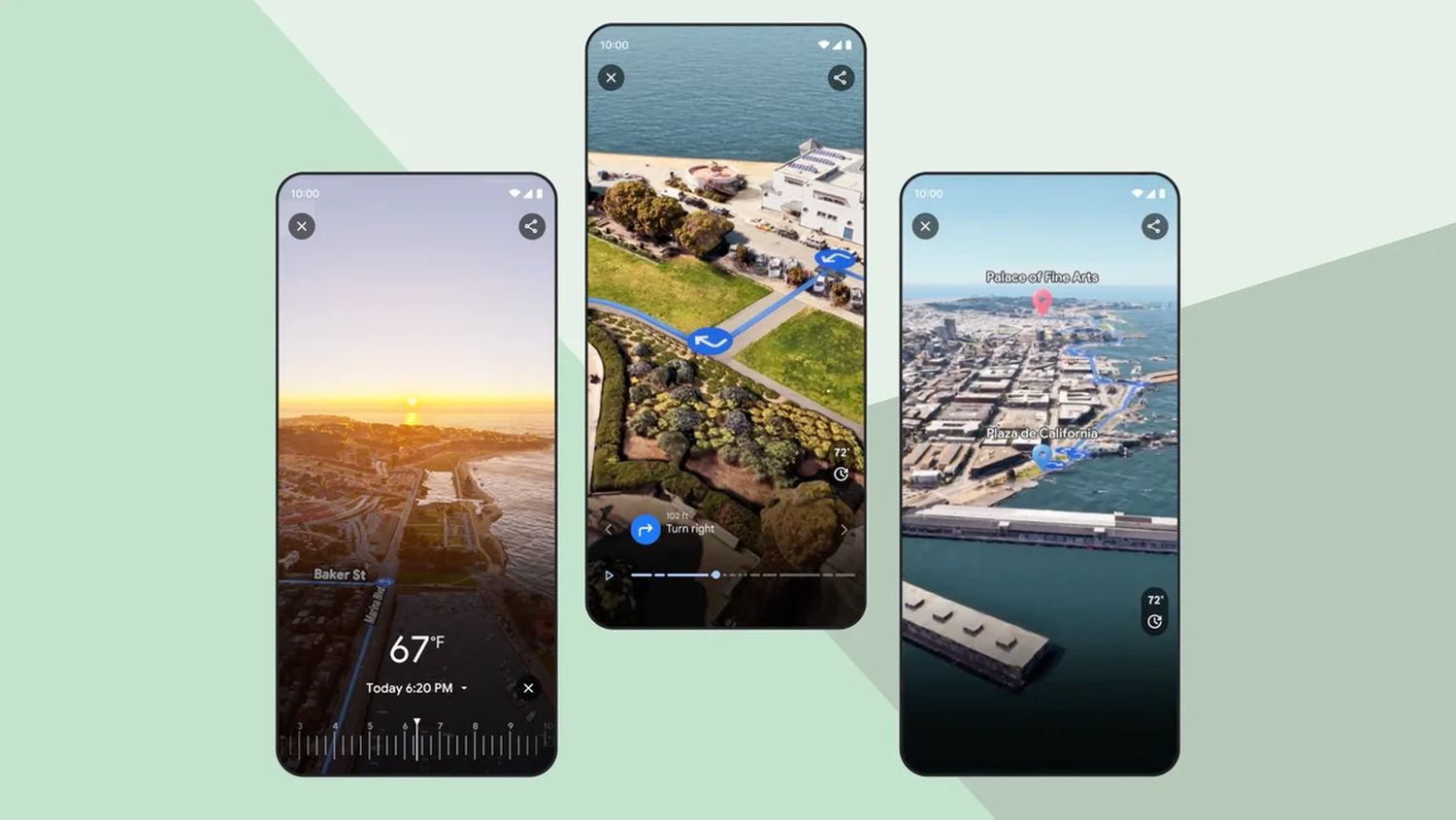

Vor einiger Zeit hat Google Maps mit den Immersive View-Ansichten eine ganz neue 3D-Ansicht eingeführt, die sich in einigen Regionen bereits etabliert hat, aber noch längst nicht überall auf der Welt zur Verfügung steht. Mittlerweile werden die Ansichten auch in einigen deutschen Städten angeboten, unter anderem auch als Immersive Routen für die Routenplanung. Mit diesem Feature gibt man den Nutzern die Möglichkeit, die gesamte geplante Fahrstrecke in einer beeindruckend realistischen 3D-Ansicht zu erkunden und Details zu erkennen, die sonst weder auf der Karte, der Satellitenansicht noch in Streetview sichtbar wären. Denn Immersive View ist eine Kombination aus vielen verschiedenen Daten- und Bildquellen.

Im Google Maps-Blog erklären die Entwickler ausführlich, wie das Immersive View funktioniert. Weil die Umsetzung sehr technisch und hochkomplex ist, findet ihr hier nur eine Kurzfassung und könnt euch bei Interesse das englische Original im Google-Blog durchlesen. Ein kurzer Teaser verdeutlicht schon, dass es eine technische Herausforderung gewesen sein muss. Man spricht vom größten Puzzle der Welt.

Zunächst werden Milliarden von hochauflösenden Bildern zusammengetragen. Diese Bilder werden dann in einem Prozess zusammengefügt: fast so, als würde man das größte Puzzle der Welt zusammensetzen.

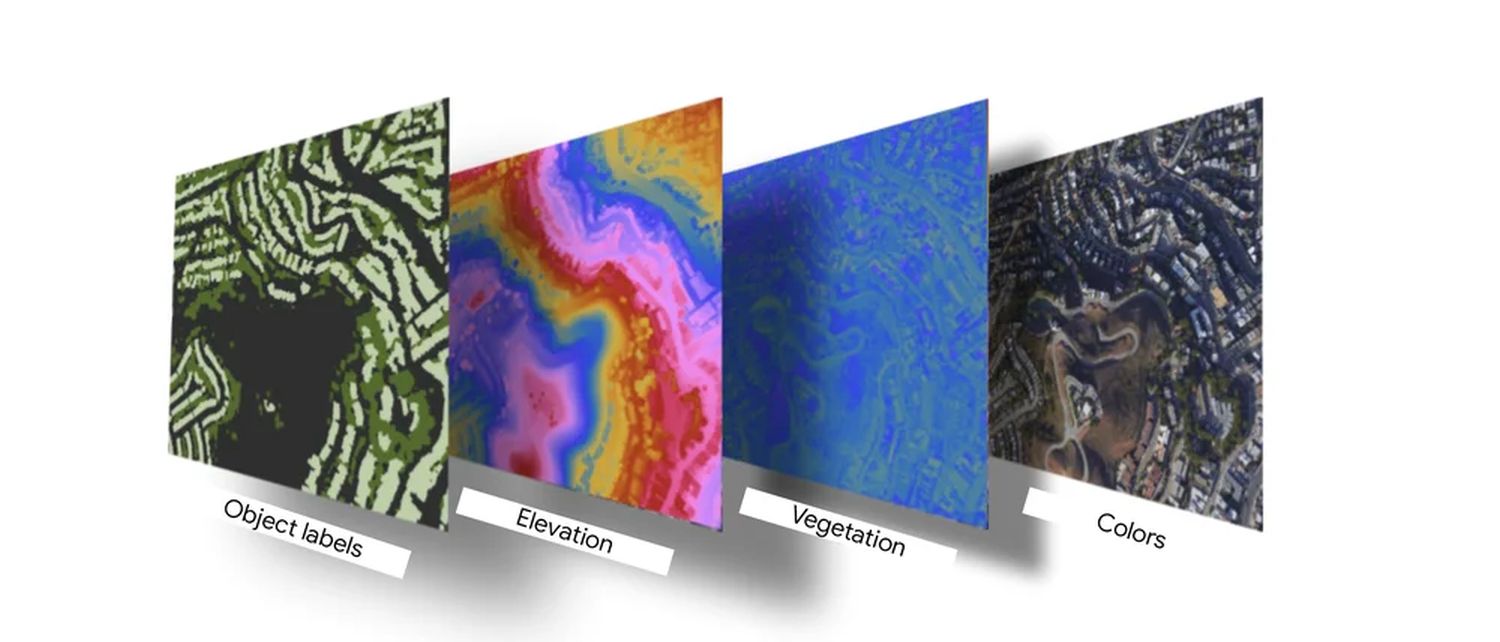

Den Grundstein für die Darstellung legen mehrere Milliarden Bilder aus den unterschiedlichsten Quellen, die zu einem 360 Grad-Layer zusammengefasst werden. Dazu können sowohl Satellitenbilder, Flugzeugfotos, Streetview-Aufnahmen als auch einige weitere Quellen zählen. Wie ihr auf der unten eingebundenen Grafik sehen könnt, gehört dazu auch eine Höhenkarte, um die grundlegende Darstellung von Gelände, Straßen und Gebäuden korrekt wiederzugeben.

Laut den Angaben im Google-Blog soll das reine Zusammenfügen der Bilder vergleichsweise einfach sein, denn diese Aufgabe konnte man an die über viele Jahre trainierten KI-Modelle abgeben. Diese werden schon seit Jahren auch für Satellitenfotos und Streetview-Aufnahmen verwendet. Die Schwierigkeiten liegen in einem ganz anderen Bereich, nämlich bei der Anpassung. Denn das Bildmaterial muss exakt an das vorhandene Google Maps-Kartenmaterial angepasst werden. Und dabei reden wir nicht von einer groben Platzierung in Metern, sondern auf den letzten Zentimeter genau. Ist das nicht der Fall, würde das bei einem 3D-Modell sofort sehr negativ auffallen.

Theoretisch klingt das recht simpel, aber mehrere Faktoren machen diesen Prozess recht komplex: Das gesamte Bildmaterial muss mit den vorhandenen Google Maps-Daten abgeglichen werden, damit alle Straßen, Wege und Geschäftsnamen zusammenpassen. Dies ist nur mit unseren fortschrittlichen Photogrammetrietechniken möglich, die Bilder und Daten auf den Zentimeter genau abgleichen können.

Von Google selbstentwickelte Technologien machen es möglich, die Objekte, Straßenverläufe, Fahrzeuge, Verkehrsschilder und noch einiges mehr erkennen zu können, um diese mit den Kartendaten aus Google Maps abzugleichen. Hat man diesen Schritt genommen und die 2D-Bilder an exakter Stelle auf die Karte gebracht, geht es mit der nächsten Stufe weiter. In diesem Schritt müssen die gesamten Medien in ein 3D-Modell umgerechnet werden. Das ist die Grundlage dafür, dass sowohl die Nutzer als auch die Routenplanungs-Algorithmen die Karte beliebig schwenken, drehen, kippen und anderweitig bewegen können.

Ist das 3D-Modell fertig berechnet, muss noch die Routenplanung ihre Arbeit verrichten. Auch das scheint eine größere Herausforderung zu sein, als man es im ersten Moment annehmen würde. Denn die auf der Karte platzierte blaue Linie für die Route muss exakt auf die Straßen gelegt werden. Dabei kann es gerade in Städten sehr häufig vorkommen, dass die eigentliche Linie von Gebäuden, Bäumen und anderen Erhebungen verdeckt wird. Das sorgt gleichzeitig für einen erhöhten Realismus der gesamten Darstellung.

Daten verarbeiten

Sobald wir die Bilddaten zusammengefügt haben, setzen wir KI und Computer Vision ein, um zu verstehen, was auf ihnen zu sehen ist. Innerhalb von Sekunden können unsere Modelle für maschinelles Lernen Elemente auf einem Foto erkennen – wie Gehwege, Straßenschilder, Schilder mit Geschwindigkeitsbegrenzungen, Straßennamen, Adressen, die angegebenen Öffnungszeiten und Gebäudeeingänge. Diese Modelle wurden anhand von Millionen von Fotos aus der ganzen Welt trainiert, so dass sie in der Lage sind, sich an verschiedene Regionen anzupassen und zu lernen. So können sie zum Beispiel ein „SLOW“-Schild in den USA erkennen, das eine gelbe oder orangefarbene Raute ist – und in Japan, das dreieckig und überwiegend weiß und rot ist.

Das Verständnis dieser Bildelemente hilft uns, euch die nützlichsten Informationen in Immersive View für Routen anzuzeigen. So könnt ihr euch zum Beispiel direkt zum Eingang eines Gebäudes navigieren lassen, was euch davor bewahrt, ein paar Runden um den Block zu drehen!

| # | Vorschau | Produkt | Preis | |

|---|---|---|---|---|

| 1 |

|

TomTom Pkw-Navi GO Classic 2nd (6 Zoll, Stauvermeidung Dank TomTom Traffic, Karten-Updates Europa... |

159,00 EUR

119,00 EUR |

Bei Amazon kaufen |

| 2 |

|

TomTom Pkw-Navi GO Classic 2nd (5 Zoll, Stauvermeidung Dank TomTom Traffic, Karten-Updates Europa... |

139,00 EUR

99,00 EUR |

Bei Amazon kaufen |

| 3 |

|

TomTom Pkw-Navi GO Classic Lite (6 Zoll, TomTom Traffic, Karten-Updates für Europa inklusive,... |

139,00 EUR

115,00 EUR |

Bei Amazon kaufen |

| 4 |

|

GPS Navigationsgerät fùr Auto 2025,GPS Navigation Navi Auto LKW 5 Zoll Testsieger mit... |

59,89 EUR

57,31 EUR |

Bei Amazon kaufen |

Letzte Aktualisierung am 2025-12-09 / Bilder von der Amazon Product Advertising API / Affiliate Links, vielen Dank für eure Unterstützung! Als Amazon-Partner verdiene ich an qualifizierten Verkäufen.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter