Pixel Screenshots & Gemini Live: Die ersten Schritte zur visuellen KI; Google zeigt Smart Glasses-Zukunft (Video)

Google hat in den letzten Wochen sehr viele Ankündigungen rund um die Pixel-Smartphones und die Gemini-KI machen können, wobei es natürlich auch das eine oder andere Highlight gegeben hat. Zwei vollkommen voneinander unabhängige neue Produkte, die bisher vielleicht etwas unter dem Radar geflogen sind, könnten in Zukunft vor allem gemeinsam noch eine sehr wichtige Rolle spielen. Denn sie sind die Vorboten der visuellen Gemini-KI.

Im Rahmen des ‚Made by Google‘-Events im August hatte Google unter anderem das neue Gemini-Format Gemini Live angekündigt sowie das neue Pixel-Feature Pixel Screenshots erstmals offiziell gezeigt. Wir haben euch beide Funktionen in den verlinkten Artikeln ausführlich vorgestellt, die ohne weitere Verzögerung zunächst nur für Advanced-Abonnenten angeboten werden. Bei Live hat sich das mittlerweile geändert, denn vor wenigen Tagen wurde Gemini Live für alle Nutzer geöffnet.

Gemini Live könnte man als Weiterentwicklung der fortgesetzten Kommunikation mit dem Google Assistant beschreiben und Pixel Screenshots ist nichts anderes als eine Bilderkennung mit integriertem Textspeicher. Beides sehr praktisch, aber nicht aufregend. Doch wenn wir einen Schritt weitergehen und die Möglichkeiten dieser beiden Technologien miteinander kombinieren, kommen wir plötzlich bei einem ganz anderen Produkt heraus, das Google schon einmal in Aussicht gestellt hat: Nämlich die visuelle Gemini-KI für Smart Glasses.

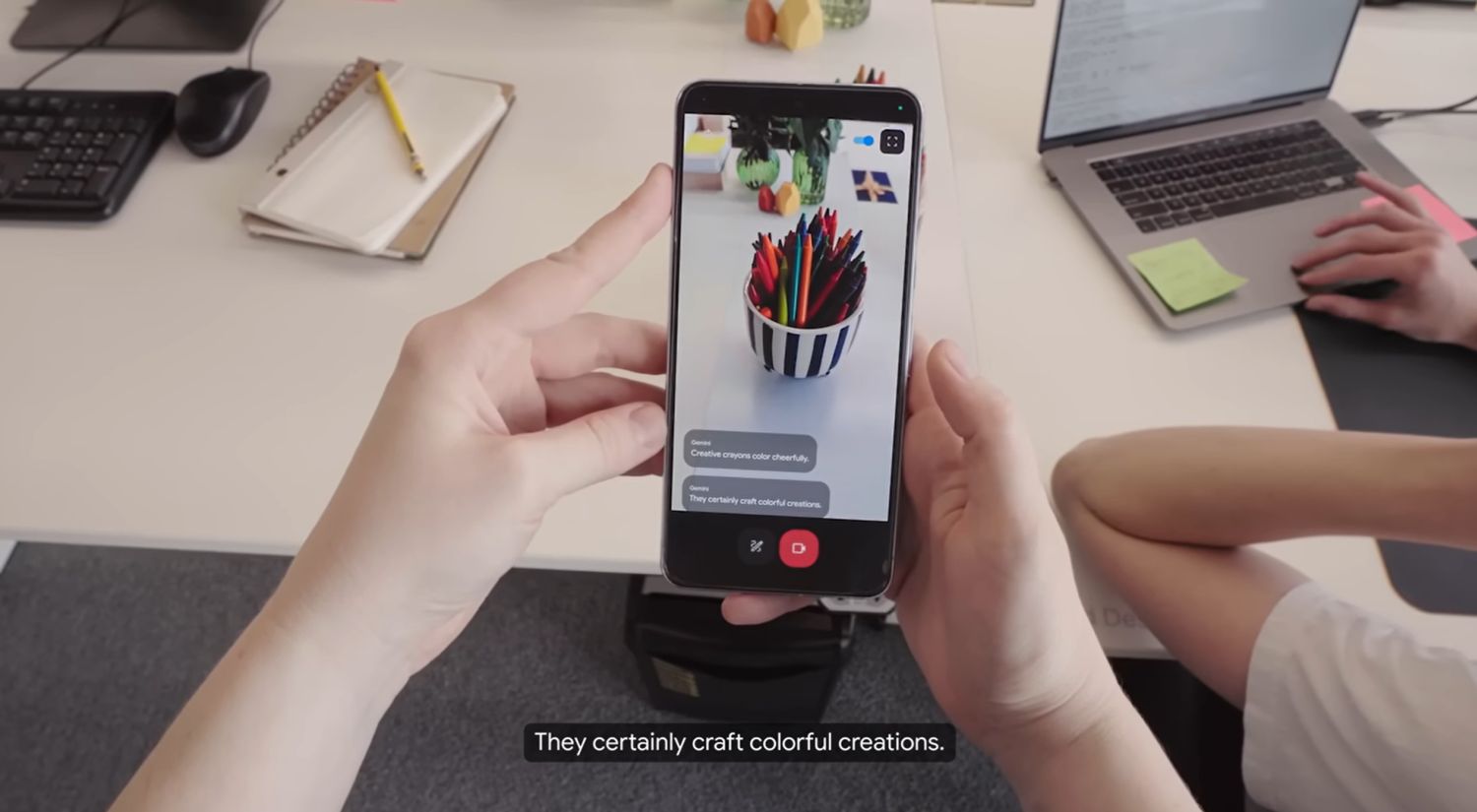

Auch die visuelle Gemini-KI haben wir euch bereits im verlinkten Artikel ausführlich vorgestellt, die von Google bei der Präsentation im Mai als reines Konzept beschrieben wurde. Tatsächlich liefert man mit Gemini Live und Pixel Screenshots aber genau die Zutaten, die es dafür braucht, um dieses Tool schon bald in der Form umsetzen zu können, wie man es in dem unten eingebundenen Video im Mai in Aussicht gestellt hat.

Pixel Screenshots durchsucht Bilder nach Text und Objekten, die es sich merkt. Für das neue Produkt muss man das Ganze vom statischen Bild auf ein Live-Video erweitern, was zwar einiges an Rechenkapazität benötigen wird, aber mit Google Lens oder Google Lookout schon längst gezeigt wurde. Für das multimodale Gemini macht es keinen Unterschied, ob es ein Bild oder ein Video ist. Statt also ein unendliches Live-Video aufzunehmen, wird sich Gemini nur Informationen, Positionen, Beschreibungen und Meta-Daten merken.

Gemini Live kommt ins Spiel, um auf solche Dinge zu achten, auf Anweisungen vom Nutzer zu warten oder Fragen zu beantworten. Gemini Live ist die Schnittstelle zwischen KI und Mensch, während Pixel Screenshots (dann natürlich mit einem anderen Namen) die visuelle Komponente übernimmt. Das scheint alles gar nicht so weit entfernt zu sein, wie man es im obigen Video noch vermuten würde.

Meine Prognose lautet daher: Man zeigt obiges Demovideo auf der nächsten Google I/O noch einmal, dann mit einem realen Produkt, und rund um ‚Made by Google 2025‘ erhalten wir die ersten Smart Glasses, für die Google derzeit nach Partnern sucht.

| Vorschau | Produkt | Preis | |

|---|---|---|---|

|

|

Google Pixel 9 – Android-Smartphone mit Gemini ohne SIM-Lock, erweiterte Kamerafunktion, 24... |

999,00 EUR

735,90 EUR |

Bei Amazon kaufen |

|

|

Google Pixel 9 Pro – Android-Smartphone mit Gemini ohne SIM-Lock, Dreifach-Rückkamerasystem, 24... |

1.329,00 EUR

1.178,99 EUR |

Bei Amazon kaufen |

|

|

Google Pixel 9 Pro Fold – Android-Smartphone mit Gemini ohne SIM-Lock – fortschrittliches... |

1.899,00 EUR

1.599,00 EUR |

Bei Amazon kaufen |

|

|

Google Pixel Watch 3 (45 mm) – Android smartwatch with Heart Rate Tracking, Advanced Running from... |

449,00 EUR

349,00 EUR |

Bei Amazon kaufen |

Letzte Aktualisierung am 2025-03-29 / Bilder von der Amazon Product Advertising API / Affiliate Links, vielen Dank für eure Unterstützung!

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter