Google Assistant & Google Lens: Neue Bildschirmsuche erhält wohl altbekannte Geste zurück (Teardown)

Nach einer etwas längeren Pause hat man dem Google Assistant in Kombination mit der smarten Bilderkennung Google Lens kürzlich wieder die Möglichkeit spendiert, den Bildschirminhalt zu erkennen. Bisher ist diese Funktion nicht ganz so komfortabel zugänglich, doch mit dem kommenden Android 14 Feature Drop-Update wird Google wohl eine altbekannte Geste zurückbringen.

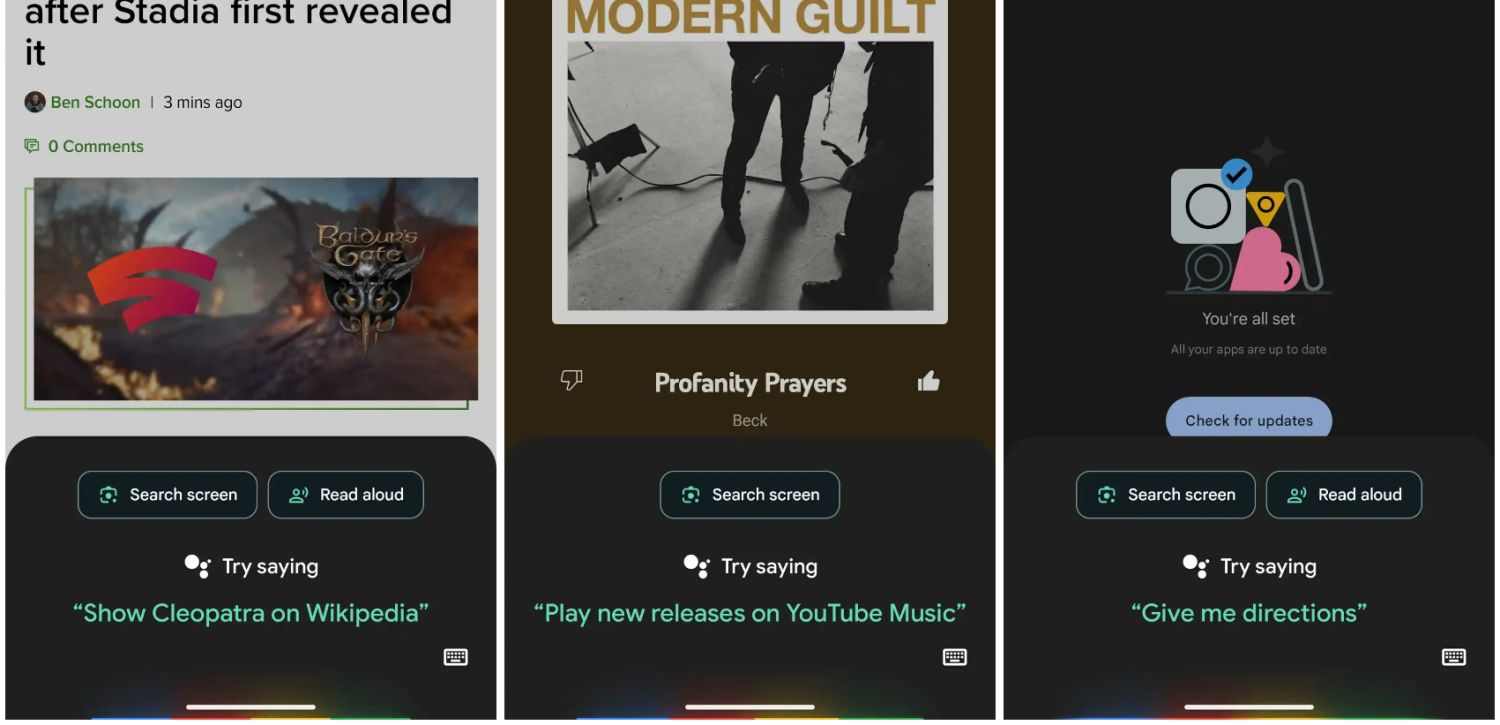

Google Assistant und Google Lens haben gemeinsame Wurzeln, haben sich in den letzten Jahren eher auf die eigene Richtung konzentriert und wachsen jetzt wieder etwas mehr zusammen: Wird der Google Assistant per Knopfdruck oder Sprachbefehl aufgerufen, erscheint dieser unter Android mit einem Overlay am unteren Rand. Dort findet sich nach einem der jüngsten Updates der neue Button „Search Screen“, mit dem sich das Bildschirmfoto an Google Lens senden und analysieren lässt. Obwohl Lens zum Einsatz kommt, wird es zumindest am Button nicht als solches bezeichnet. Dieses Feature ist bei weitem nicht neu, aber heute etwas anders umgesetzt.

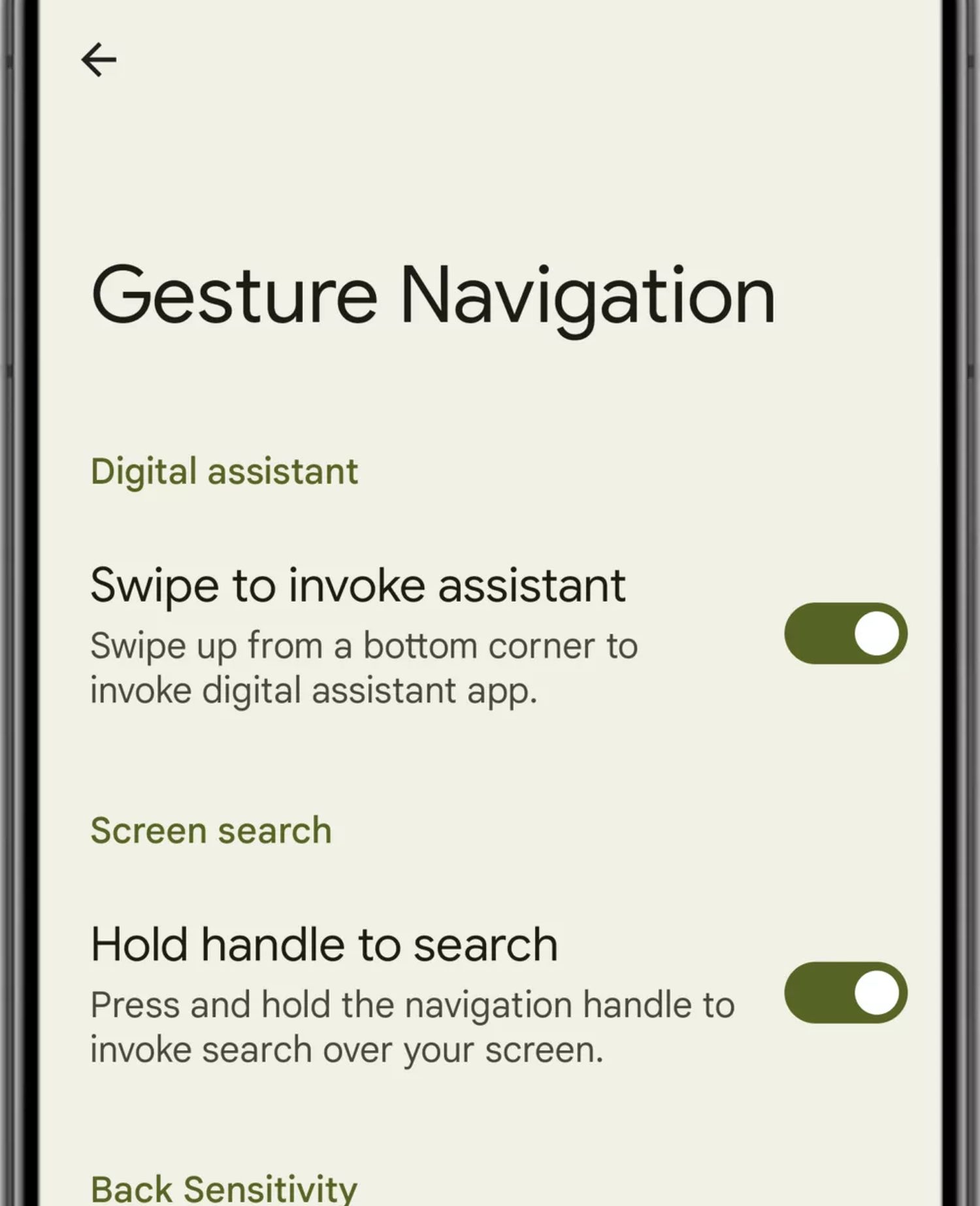

Um es einfacher erreichbar zu machen, lässt sich in der Android 14 QPR1 Beta nun nach umlegen einiger interner Schalter eine neue Geste freischalten. Diese ist bisher nicht funktional, aber eindeutig beschrieben: Wird die Navigationsleiste am unteren Rand des Smartphones gedrückt gehalten, startet der Assistant in diesem Modus – so wie das früher mit dem Home-Button der Fall war. Dennoch dürfte der Button in der Assistant-Oberfläche weiterhin verfügbar bleiben, denn Lens findet fast immer etwas. Lediglich am Homescreen wird die Funktion nicht angeboten.

» Android 14: Wie oft wurde das Smartphone aufgeladen? QPR1 Beta bringt neue Akku-Infos (Screenshots)

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter