Android: Neue Google-App ermöglicht Smartphone-Steuerung mit Gesichtsbewegungen per Kameraschalter

Google hat vor wenigen Tagen eine neue Android-App veröffentlicht, mit der sich Smartphones ganz im Sinne der Barrierefreiheit auf alternativen Wegen steuern lassen – nämlich per Schalterzugriff. Aber das ist längst nicht alles, denn die App erlaubt auch eine Gesichtssteuerung, die überraschend gut funktioniert. Mit recht eindeutigen Bewegungen lassen sich eine Reihe von Aktionen zur Steuerung auslösen.

Smartphones werden hauptsächlich per Touchbedienung gesteuert, ergänzend vielleicht per Spracheingabe, aber primär mit Tippen und Wischen auf dem Display. Das ist intuitiv und einfach, aber nicht für alle Menschen möglich, sodass das Thema Barrierefreiheit auch auf den mobilen Geräten eine große Rolle spielt. Google hat vor einigen Tagen die App Schalterzugriff veröffentlicht, die die Anbindung und Steuerung per Tastschalter und Regler ermöglicht.

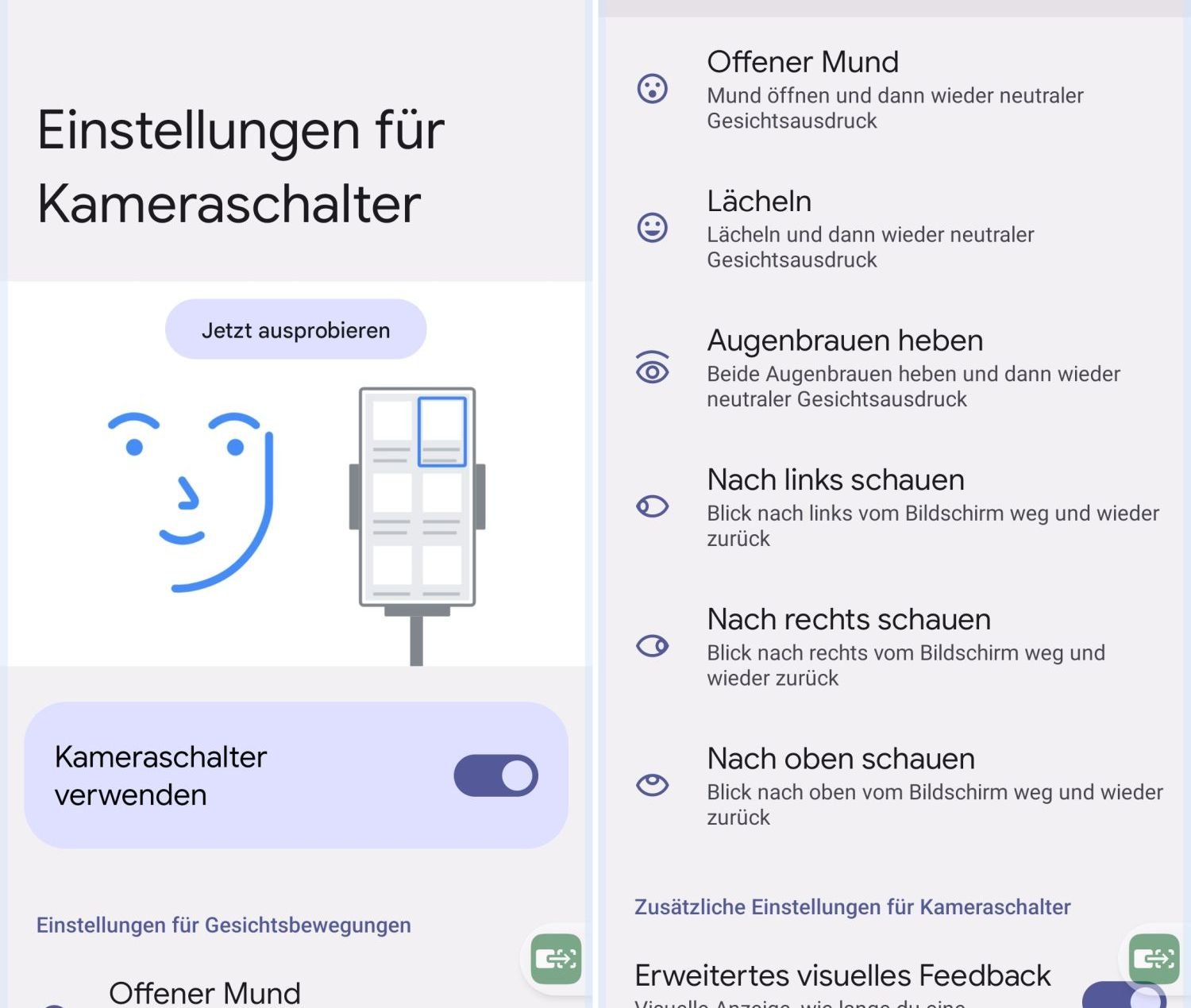

Zusätzlich bietet die App die Möglichkeit, das Smartphone mit „Gesichtsbewegungen“ zu steuern, mit denen sich Eingaben und bestimmte Aktionen simulieren lassen. Ähnlich wie bei der Schaltersteuerung geht es nicht um eine intuitive Nutzung, sondern um die Erkennung spezieller Signale, die wiederum in zuvor ausgewählte Aktionen übersetzt werden. Die App bietet sechs verschiedene Gesichtsaktionen an, die erkannt, personalisiert und verbunden werden können.

Ich bin auf solch eine Steuerung nicht angewiesen, habe sie aber dennoch aus reinem Interesse einmal installiert, eingerichtet und ausprobiert – so wie man jede andere Bedienhilfe oder barrierefreie Tools jederzeit aktivieren kann, sofern sie keine zusätzliche Hardware benötigen. Einfach die App herunterladen, in den Bedienhilfen freischalten und schon könnt ihr damit beginnen, das Smartphone mit Gesichtsbewegungen zu steuern.

Als Eingabemöglichkeit stehen euch sechs verschiedene Aktionen zur Verfügung: Mund öffnen, Lächeln, Augenbrauen anheben, nach Links schauen, nach Rechts schauen und nach oben schauen. Das sind nicht viele Aktionen, aber durch eine Verknüpfung ergeben sich dennoch nahezu alle Möglichkeiten: Mit nur zwei Aktionen lässt sich jedes beliebige Element auswählen und ausführen. Das dauert natürlich deutlich länger als eine Touch-Bedienung, aber darauf angewiesenen Menschen gibt das eine völlig neue Freiheit – ein unschätzbarer Wert.

Ich muss sagen, dass das bei mir grundsätzlich gut funktioniert hat, aber natürlich ist es umständlich und zu Beginn auch anstrengend. Denn ihr nutzt plötzlich Gesichtsmuskeln (z.B. Augenbrauen heben), die ihr normalerweise selten oder unbewusst nutzt – und das bemerkt ihr ziemlich schnell. Lange Zeit habe ich es nicht genutzt, aber es ist ein interessantes und einfach nutzbares Experiment, um sich auch mit solchen Themen zu beschäftigen. Die Algorithmen sind meiner Meinung nach „perfekt“ und erkannten auch leichte Bewegungen zuverlässig.

| # | Vorschau | Produkt | Preis | |

|---|---|---|---|---|

| 1 |

|

Tapo TP-Link C200 360°-WLAN-Überwachungskamera für den Innenbereich, FHD 1080P, Nachtsicht,... |

39,90 EUR

26,90 EUR |

Bei Amazon kaufen |

| 2 |

|

Tapo C200C 360°-WLAN-Überwachungskamera für den Innenbereich, 1080P, Nachtsicht,... |

24,90 EUR

17,96 EUR |

Bei Amazon kaufen |

| 3 |

|

TP-Link Tapo C210 WLAN IP Kamera Überwachungskamera (Linsenschwenkung und Neigung, 3MP-Auflösung,... |

25,13 EUR |

Bei Amazon kaufen |

| 4 |

|

Digitalkamera 1080P Fotokamera 44MP Kamera Fotoapparat Tragbare Kompaktkamera mit 2,4" LCD... |

99,99 EUR

59,99 EUR |

Bei Amazon kaufen |

Letzte Aktualisierung am 2025-04-05 / Bilder von der Amazon Product Advertising API / Affiliate Links, vielen Dank für eure Unterstützung!

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter