Android: Das ist Google Lookout – starker Lens-Ableger zur Beschreibung von Objekten und Dokumenten (Video)

Google hat sehr viele Apps im Portfolio, wobei längst nicht alle bei Millionen von Nutzern zum Einsatz kommen – auch, weil sie kaum bekannt sind. In diese Kategorie dürfte auch Google Lookout fallen, das man als kleinen Bruder von Google Lens bezeichnen könnte und es sehbehinderten Menschen ermöglichen soll, viele Dinge zu erkennen. Mit dem jüngsten Update wird die App noch viel stärker.

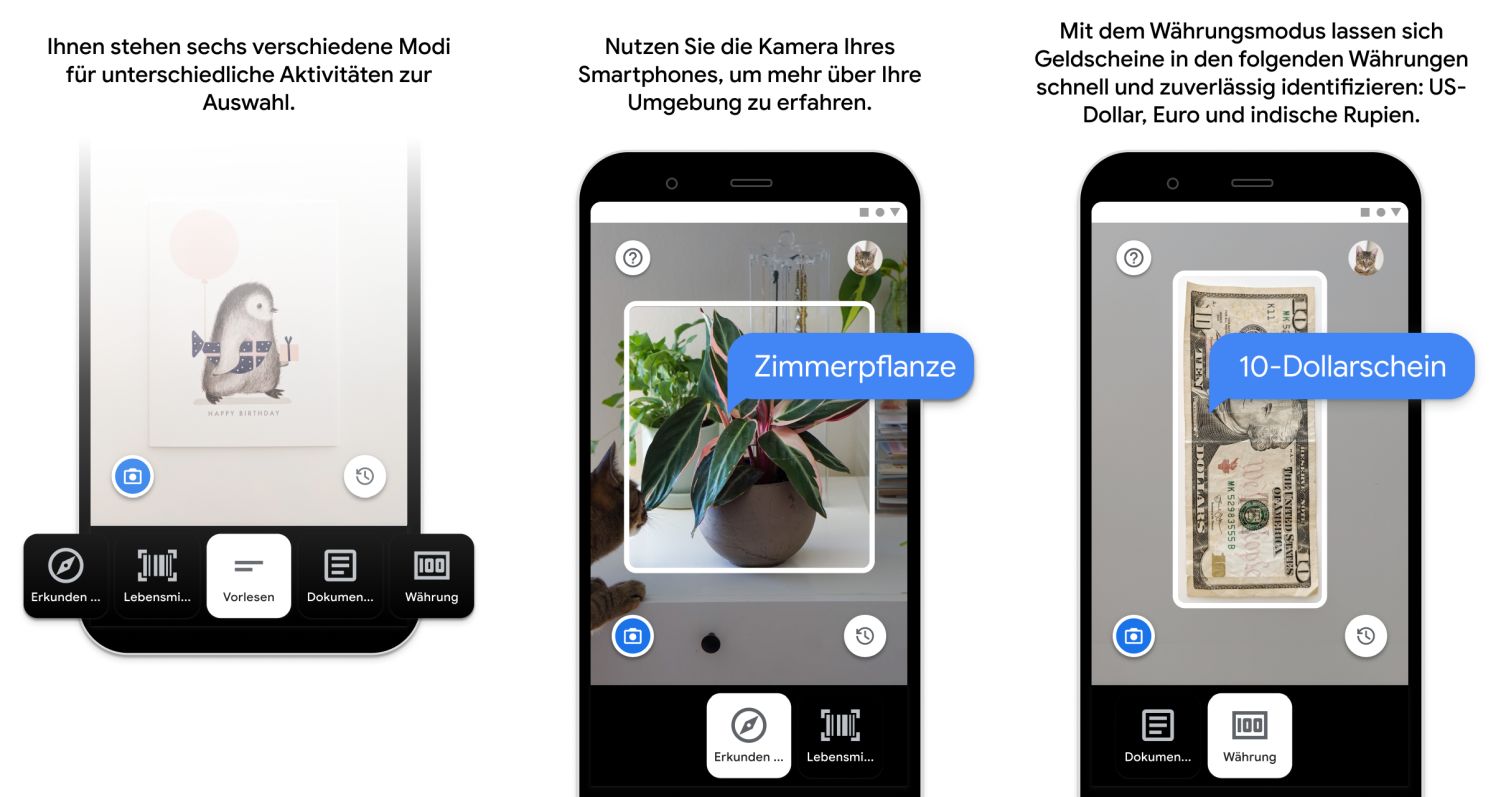

Google Lookout wurde schon vor vier Jahren vorgestellt und hat es sich zur Aufgabe gemacht, Objekte, Produkte, Dokumente und Texte zu erkennen, den Nutzern akustisch zu beschreiben und damit erkennbar zu machen. Die App erkennt die aufgelisteten Dinge im Kamerabild oder auf geöffneten Fotos und kann im Alltag der darauf angewiesenen Menschen sicherlich eine extrem große Stütze sein. Es ist vergleichbar mit Google Lens, nur dass es hier nicht um weitere Informationen zu Objekten geht, sondern diese hauptsächlich beschrieben werden sollen.

Das funktioniert erstaunlich gut und kann sehr viele Objekte beschreiben, die vor die Kamera gehalten werden. Das Ganze funktioniert im Livebild, sodass es so nativ wie möglich nutzbar ist und keine perfekten Fotos oder so etwas benötigt. Ohnehin wäre es für die Nutzer wohl nicht so einfach, die Objekte perfekt zu fotografieren. Dennoch hat das jüngste Update jetzt die Möglichkeit mitgebracht, Bilder aus beliebigen Apps mit Lookout zu teilen, um diese auszuwerten.

Außerdem hat das jüngste Update ein Feature an Bord, mit dem sich die App ohne Internetverbindung nutzen lässt. Das ist schon sehr beeindruckend, denn schließlich muss man eine unglaublich große Datenbank an Objekten lokal auf das Smartphone bringen, um diese zu erkennen. Und dabei geht es nicht nur um grobe Erkennungen, sondern immer weiter ins Detail. Man hebt besonders die Erkennung von Lebensmittelpackungen hervor. Wohlgemerkt anhand der Verpackung, nicht des Strichcodes.

Es geht aber nicht nur um die Objekterkennung, sondern um die Wahrnehmung der Umwelt und auch Stück weit darum, etwas zu finden. So hatte man zu Beginn etwa damit geworben, den Nutzern den Weg zur Toilette anhand von Hinweisschildern zu weisen. Dafür muss also das Kamerabild Live erfasst, von der KI ausgewertet und nach nützlichen Informationen durchforstet werden. Dass man so etwas als App auf ein Smartphone bringt und kostenlos anbietet, ist schon stark.

Hauptsächlich richtet sich die App an sehbehinderte Menschen, sie kann aber auch für alle anderen recht interessant sein, um sich die Technologie anzusehen, sich einmal den Alltag beschreiben zu lassen oder einfach eine andere Form der Bildauswertung zu testen. Die App steht im Play Store frei zur Verfügung und könnte somit eine ideale Ergänzung zu Google Lens sein, das im Hintergrund vermutlich auf der gleichen Technologie und einer verwandten Datenbank basiert.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter