Google Lens: Großes Upgrade kombiniert erstmals Bild und Text – das ist das neue Multisearch (Galerie)

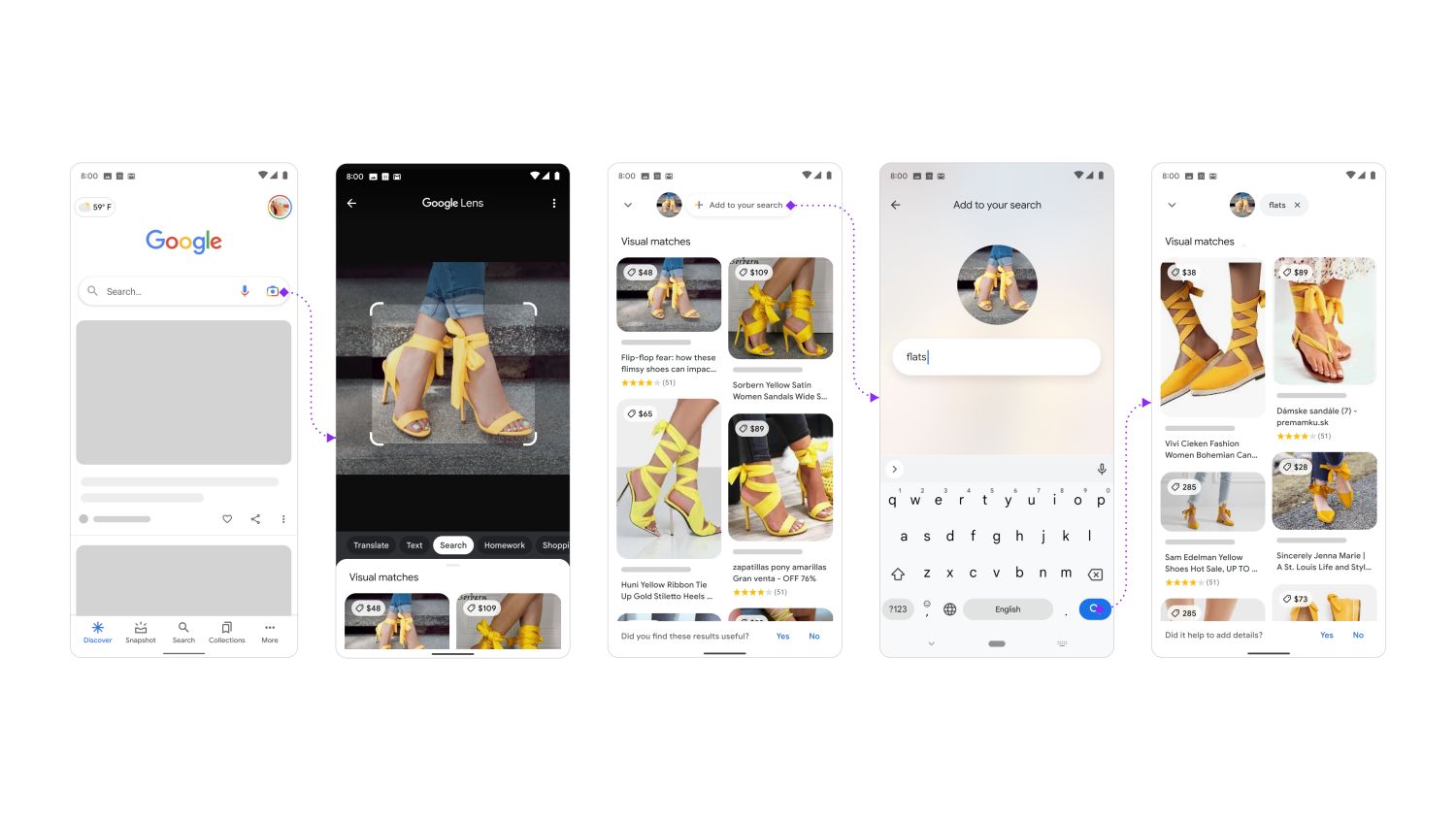

Nach Jahren der Eigenständigkeit wurde erst vor wenigen Tagen das neue Google Lens Multisearch angekündigt, mit dem die smarten Augen des Google Assistant in die Websuche integriert werden sollen. Konkret geht es um die Kombination aus Bild und Text, die nun erstmals in dieser Form möglich sein wird. In einigen Beispielen zeigt sich nun, wofür man so etwas benötigen könnte.

Die Google Websuche ist nicht mit der Version vor zwei Jahrzehnten zu vergleichen, aber dennoch beginnt nach wie vor jede Suchanfrage gleich: Mit Text. Schon seit vielen Jahren sprechen die Entwickler davon, eines Tages eine multimediale Komponente hereinzubringen und mit anderen Suchtypen beginnen zu können, aber erst in dieser Woche war es soweit: Mit dem Start von Google Lens Multisearch kann die Suche nach Bild bzw. Objekt und Text begonnen werden.

Das klingt sehr praktisch, aber vielleicht fragt sich der eine oder andere, wofür das überhaupt benötigt wird. Die Suche nach Bildern scheint noch nicht wirklich in der Masse angekommen zu sein, was Google sicherlich ändern möchte. Wir haben euch schon vor längerer Zeit gezeigt, wie ihr mit Google nach ähnlichen Bildern suchen könnt und heute folgen einige Beispiele für den Einsatz von Multisearch. Es geht vor allem um das Onlineshopping und die Suche nach Produkten.

Leider muss es bei den Bildern und Videos bleiben, denn Google Lens bietet das Feature derzeit nur auf Englisch und auch nur in der US-Version der Websuche an. Vermutlich ein Testlauf, der noch längerer Zeit bis zum globalen Rollout benötigt. Weil deutlich mehr als nur eine Mustererkennung zum Einsatz kommt, dürfte die Übersetzung einiges an Zeit in Anspruch nehmen.

Im obigen Beispiel könnt ihr sehen, wie Google Lens Multisearch auf der Suche nach Schuhen eingesetzt werden kann. Ich bin da kein Experte, aber man kann von hohen Stöckelschuhen zu Schuhen mit einfachen Absätzen und einem ähnlichen Aussehen gelangen. Schuhe scannen, „Flats“ hinzufügen und schon sollte man die gewünschten Bilder und Produkte finden. Vorausgesetzt natürlich, dass diese existieren.

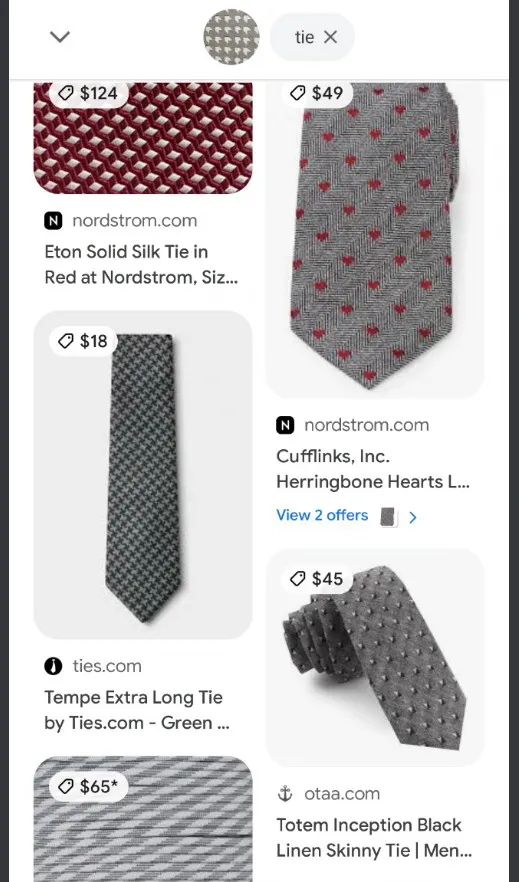

Es müssen nicht nur Damenschuhe sein, sondern auch die Herren dürfen sich freuen: Ein Nutzer hat die Tapete abfotografiert und sucht nach Krawatten mit dem gleichen Muster. Dafür wurde einfach das gewünschte Muster fotografiert, der Suchbegriff „Tie“ hinzufügt und schon darf man das gewünschte Muster um den Hals über den Brustkorb baumeln lassen.

Dasselbe Prinzip funktioniert auch mit anderen Produkten. Im obigen Beispiel wird das Titelmuster eines Notizblocks abfotografiert und über den Suchbegriff „Drapes“ der dazu passende Vorhang gesucht. Scheint zumindest in den Beispielen sehr gut zu funktionieren.

Runden wir das Ganze erneut mit der Mode ab, bei der es diesmal nicht um das Muster, sondern um das gleiche Produkt in einer anderen Farbe geht. Einfach das Kleid auf einem Bild (oder an einer Person) abfotografieren, dann durch die Eingabe von „green“ die gewünschte Farbe angeben und schon kann nach einem sehr ähnlichen Kleid in grüner Farbe geshoppt werden.

—

Ich denke, es wird deutlich, dass das Ganze derzeit vor allem ein Feature für das Onlineshopping ist. Das zeigt sich schon daran, dass die Ergebnisse stets in die mit Produkten gefüllte Bildersuche sind. Es könnte aber auch in vielen anderen Bereichen funktionieren, bei denen man Bild und Fragestellung kombinieren kann. So könnte man etwas die Kamera auf den Kölner Dom richten und fragen, wann dieser erbaut wurde. Das sollte machbar sein. Oder haltet es auf ein Haustier und fragt nach dessen Ernährung. Über Umwege ist das heute alles schon möglich, aber mit einer Integration wie in obigen Beispielen sehr viel bequemer und damit massentauglich.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Eine Kollegin hat bestimmt Sportschuhe gesucht. Diese haben ihr optisch gefallen.

Das hat schon super funktioniert. Wenn man jetzt noch dazu schreiben kann, was man genau sucht, um so besser.