Ripple: Google tritt mit der Radartechnologie Soli auf der Stelle – es funktioniert wohl nicht so gut wie erhofft

Google arbeitet seit vielen Jahren an der Radartechnologie Project Soli, die mittlerweile als Ripple bezeichnet wird und in Zukunft in mehreren Produkten zu finden sein soll. Allerdings zeigt sich, dass Googles Forscher auf der Stelle treten und weit von dem entfernt sind, was sie einmal erreichen wollten. Vermutlich ist man an physikalische oder technische Grenzen gestoßen.

Aus Googles Forschungslaboren kommen immer wieder interessante Konzepte und Ideen, die völlig unterschiedliche Wege nehmen: Manches kommt nicht über die Demo hinaus, anderes ist in den Folgejahren in Produkten zu finden und wieder andere Dinge verschmelzen mit anderen Technologien. Bei der Radartechnologie Soli ist es tatsächlich der zweite Weg, was man aufgrund der bisherigen Rückmeldungen und Möglichkeiten wohl eher nicht vermutet hätte.

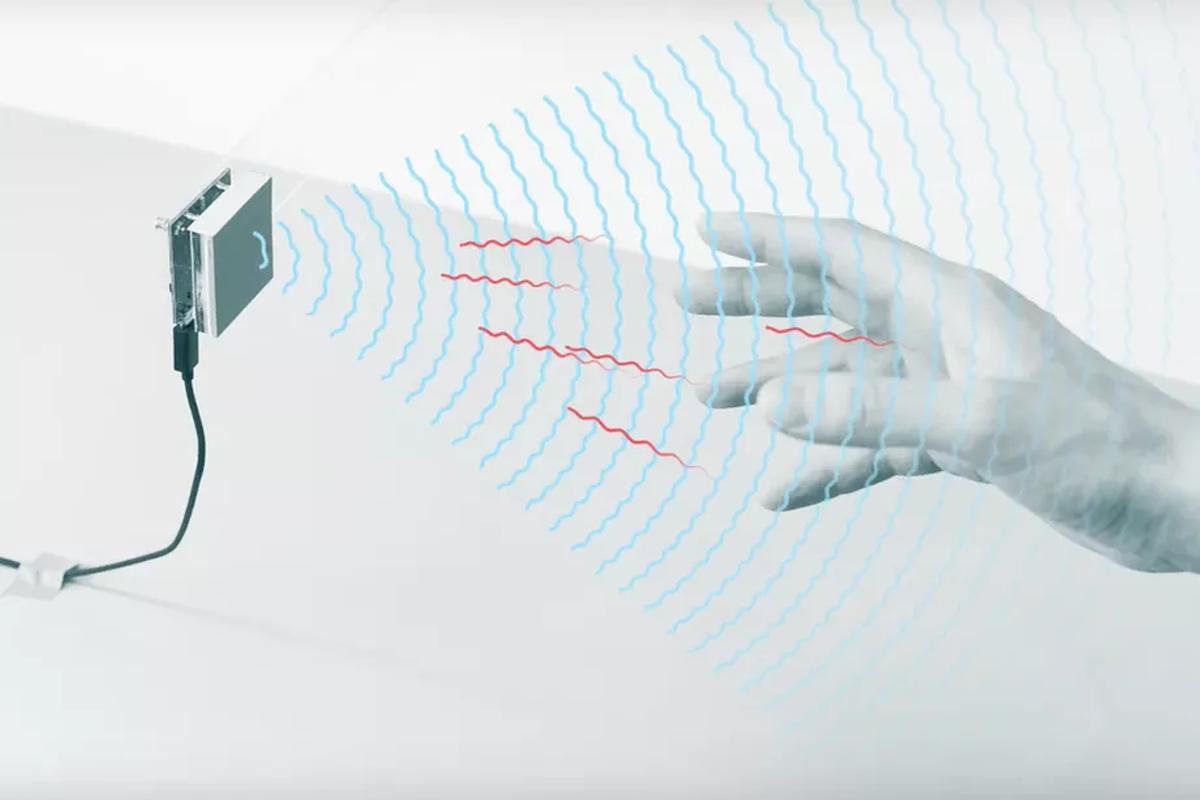

Als Soli zum ersten Mal präsentiert wurde, im Mai 2015 (!), hat man es als revolutionäre Technologie zur berührungslosen Bedienung angepriesen. Der Radarchip soll zuverlässig Hand- und Fingerbewegungen erkennen und dadurch eine Luftbedienung möglich machen. Zu sehen waren Handbewegungen, einzelne Fingerbewegungen und sogar das Bedienen von Drehknöpfen mit zwei Fingern. In den Folgejahren hatte man gezeigt, wie Soli allein auf Radar-Basis Objekte und deren Größe erfassen kann. Das war aus Endnutzer-Sicht wenig aufregend, aber dennoch ein beeindruckender Technologiesprung.

Doch offenbar funktioniert das nur unter perfekten Bedingungen oder nicht in erwarteter Zuverlässigkeit. Denn als Soli erstmals im Pixel 4-Smartphone verbaut wurde und die Steuerung per Handgeste ermöglichte, war das schon das höchste der Gefühle. Der Chip konnte bzw. kann einen Luftwisch über das Smartphone erkennen. Immerhin ist auch Richtung und Geschwindigkeit sowie Abstand erkennbar, aber das war dann auch schon alles. Von kleineren Objekten, wie etwa den Fingern des Nutzers, war gar nicht zu träumen.

Mittlerweile steckt Soli auch im Nest Thermostat sowie in einem Nest Smart Display und leistet dort exakt das Gleiche: Die Erkennung einer Handbewegung. Vor wenigen Tagen gab es einen Ausblick auf künftige Produkte mit Soli – und was war zu sehen? Exakt das Gleiche. Handbewegung und Näherung. Nichts mit Fingerbewegung, virtuellem Greifen oder der Interaktion mit Elementen. Von filigranen Bewegungen muss man gar nicht träumen, aber exakt das war schon vor sieben Jahren möglich. Und es ist nicht zu erwarten, dass noch ein Sprung folgt.

Soli funktioniert, in dem eingeschränkten Rahmen. Dennoch ist das nichts, was nicht auch ein Näherungssensor in Kombination mit einer Kamera könnte. Dass das Projekt nicht eingestellt wurde, so wie viele andere vielversprechendere Technologien zuvor, überrascht. Ich denke nicht, dass Soli in den nächsten Jahren weitere Schritte machen kann. Dafür scheint die Radar-Technologie einfach nicht ausgelegt, die ja auch sonst bekanntlich eher größere Objekte wie Flugzeuge, Hubschrauber oder Schiffe erfasst.

Vielleicht gibt es noch weitere Alternativen, mit denen man sich den Soli-Traum eines Tages erfüllen kann. Aber aus meiner Laien-Sicht muss ich sagen, dass Soli gescheitert ist. Ganz unabhängig davon, ob es nun in Produkten verbaut wird oder nicht.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter