Google forscht seit vielen Jahren an der Radar-Technologie Soli, die kürzlich in Ripple umbenannt wurde und zukünftig in mehreren Projekten zum Einsatz kommen soll. Jetzt hat man einen kleinen Ausblick darauf gegeben, wie die Nutzung von Soli bzw. Ripple in Zukunft aussehen könnte. Leider sind die Möglichkeiten nach wie vor sehr begrenzt und es scheint, als wenn Google mit der Technologie nicht vorankommt.

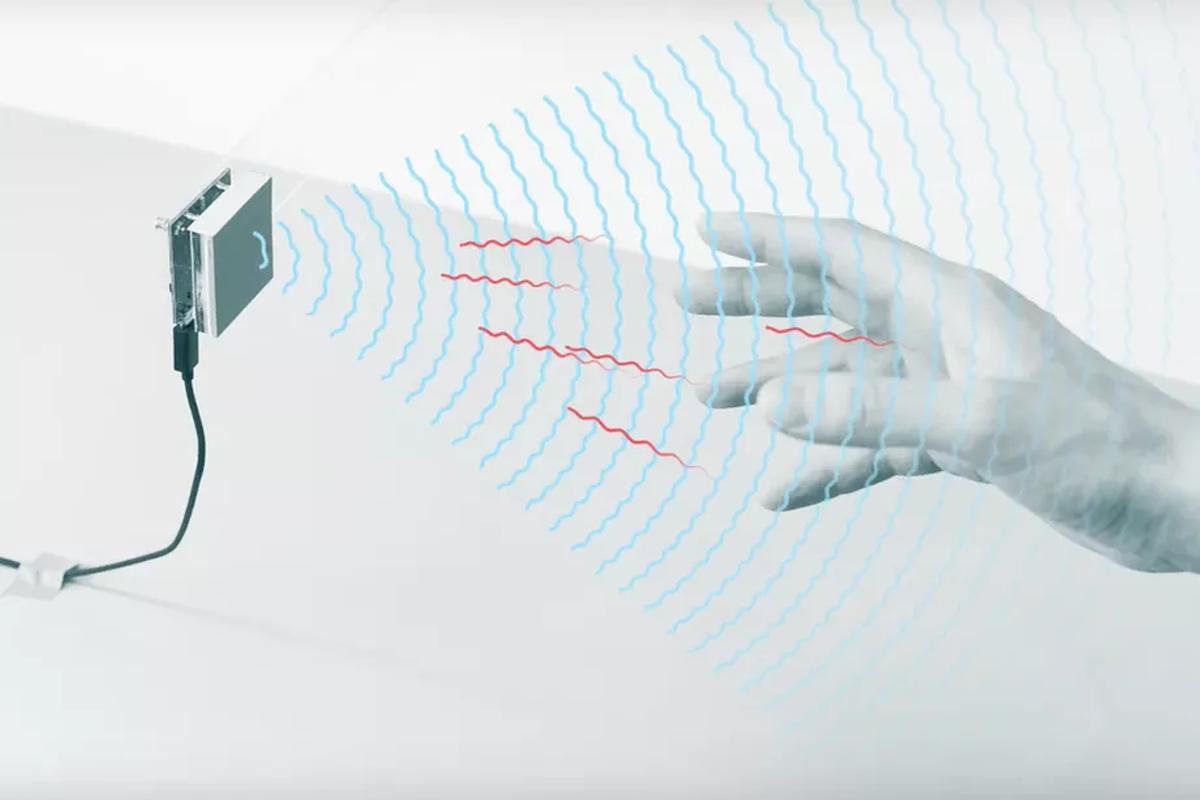

Soli war vor knapp acht Jahren ein interessantes Experiment, kam aber lange Zeit nicht über diesen Status hinaus. Auf Basis der Radar-Technologie wollte man es schaffen, die Möglichkeiten in einen winzigen Chip zu verpacken und sowohl Annäherung als auch Bewegung zu erkennen. Eben wie das klassische Radar, mit dem Flugzeuge und Schiffe erkannt werden, aber in deutlich kleinerem Rahmen und mit präziser Erkennung.

Erstmals zum Einsatz kam Soli beim Pixel 4a, wo es als große Innovation gefeiert wurde. Schlussendlich war es aber nur ein erweiterter Näherungssensor, der lediglich das großflächige Streifen mit der Hand erkennen konnte. Das mag interessant gewesen sein, konnte aber schon mein Samsung Galaxy S3 mit deutlich einfacherer Technologie. Später war es im Nest Thermostat zu finden und heute steckt Soli im Nest Hub Smart Display der aktuellen Generation, verbringt aber auch dort keine großen Wunder.

Jetzt hat sich Google dazu geäußert, wie man die Technologie in zukünftigen Produkten einsetzen möchte. Und man zeigt wieder das, was schon seit vielen Jahren zu sehen ist: Das Gerät, in diesem Fall ein in der Form noch nicht erhältliches Smart Display, reagiert auf die Annäherung des Nutzers und ändert die Darstellung.

Das Smart Display zeigt die aktuelle Temperatur oder ähnliche Informationen in großer Schrift an, sodass es aus der Ferne vom anderen Ende des Raums gut zu erkennen ist. Nähert man sich dem Display an, gibt es mehr Details und eine kleinere Größe der Schrift und der Elemente. Das ist ohne Frage sehr praktisch, aber schlussendlich nur ein erweiterter Näherungssensor. Man ist technisch keinen Schritt weitergekommen und ist weit davon entfernt, präzise Bewegungen zu erkennen. Einen Handstreich will man in späteren Produkten erkennen, einzelne Finger oder Formen allerdings nicht. Da waren schon die Forschungsvideos damals weiter, die einzelne Obstsorten und deren Größe voneinander unterscheiden konnten (nur als Beispiel).

Bleibt abzuwarten, ob Google aus diesen begrenzten technischen Möglichkeiten etwas mehr herausholen kann. Ich denke, dass man Soli als solches nicht mehr weiterentwickeln, sondern beim aktuellen Stand belassen wird. Wenn eine nähernde Person erst einmal von Soli entdeckt wurde, kann man natürlich (wenn vorhanden und nicht verdeckt) die Kamera aktivieren und entsprechend sehr viel mehr Details erkennen. Ähnlich wie bei der Gesichtserkennung auf dem Smartphone.