Google Lens: Großes Update kommt – Objekterkennung wird mit zusätzlichen Suchanfragen kombiniert (Video)

Mit Google Lens lassen sich unzählige Objekte, Texte und weitere Dinge auf Bildern erkennen, analysieren und mit weiteren Details beschreiben. Wir haben euch bereits einige Möglichkeiten gezeigt und nun zündet Google die nächste Stufe, die die bisher getrennten Bereiche Bild und Text bzw. Suchanfrage miteinander kombinieren soll. Durch die Kombination ergeben sich völlig neue Möglichkeiten.

Wir haben euch hier im Blog erst kürzlich einige Möglichkeiten von Google Lens ausführlich beschrieben, die zwar die unterschiedlichsten Bereiche abdecken, aber allesamt etwas gemeinsam hatten: Sie analysieren das Bild und spucken einige zusätzliche Informationen zu den Objekten aus, die auf diesem erkannt worden sind. Diese bestehen oftmals aus den Ergebnissen einer Google Websuche und sind somit nur der Einstiegspunkt zur weiteren Recherche.

Nun hat man ein neues Feature angekündigt, mit dem sich diese Bilder mit einer Suchanfrage kombinieren lassen. Diese wird allerdings erst in US-Englisch starten und wohl sehr lange benötigen, bis es in Deutschland bzw. in deutscher Sprache angeboten werden kann. Das Ganze funktioniert folgendermaßen: Zuerst wird das Bild gescannt, dessen Inhalt von den Algorithmen erkannt und anschließend kann eine relative Frage gestellt werden.

Relativ bedeutet in dem Fall, dass sich die Frage auf das gescannte Objekt, Produkt oder die Szenerie beziehen kann. In folgender kurzer Animation seht ihr ein Beispiel, das vom Google Lens-Team angekündigt wurde und zeigt, wie einfach sich das nutzen lassen soll. Es müssen keine Details eingegeben werden, sondern Bild und kurze Frage reicht offenbar aus.

MUM, our advanced AI model, is coming to #GoogleLens early next year. You’ll be able to snap a photo AND ask a question, which can be helpful in those moments you need to fix a broken part and have no idea what it is 🤷🔧 #SearchOn pic.twitter.com/cmedce3dB2

— Google (@Google) September 29, 2021

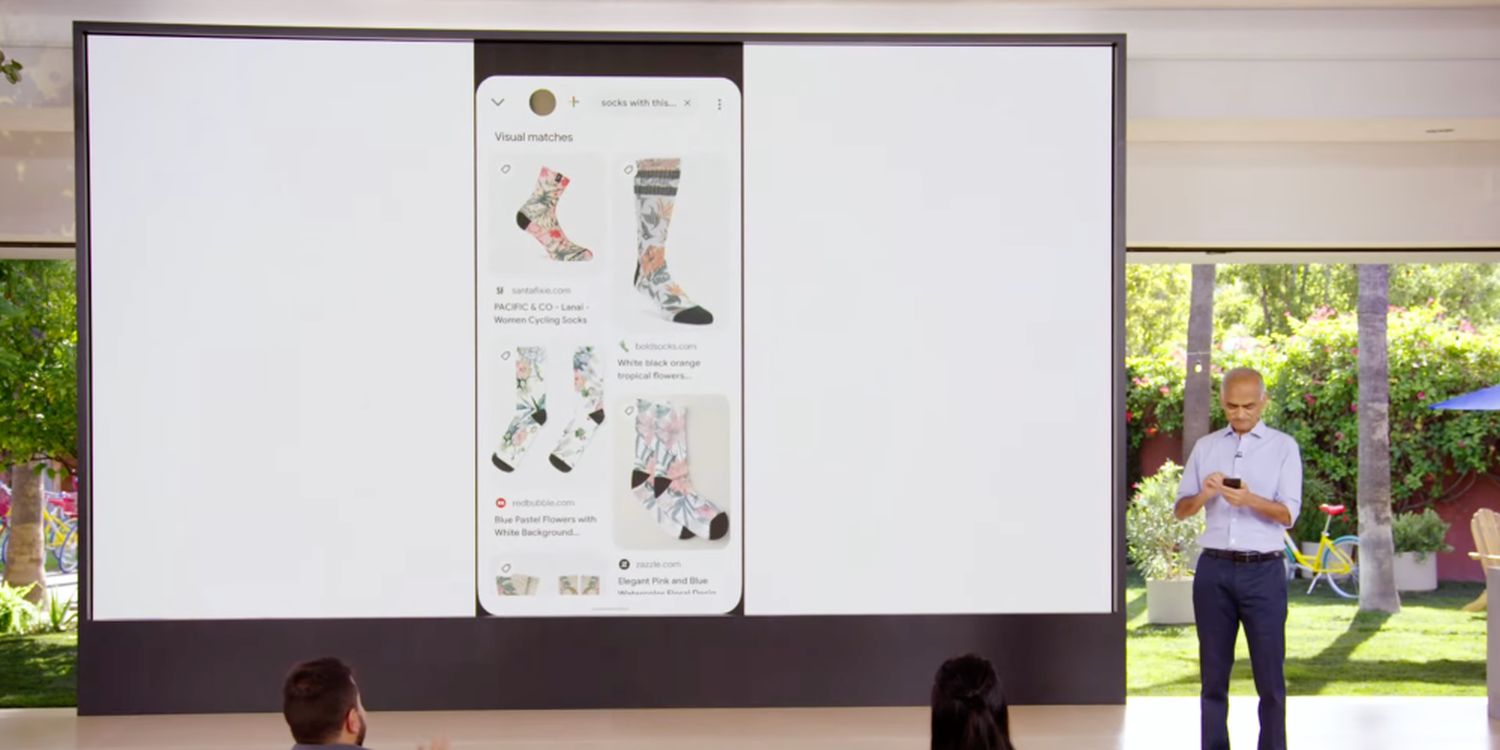

Das Ganze ist recht beeindruckend und geht in die Richtung, wie Google Lens vor einigen Jahren angekündigt wurde. Gerade dieses Beispiel scheint aber recht einfach zu sein, denn vermutlich muss im Hintergrund nur das Wörtchen „this“ durch das erkannte Objekte ersetzt werden. Als weiteres Beispiel hat man die Produktsuche herangezogen: So sollen sich Socken scannen und durch eine zusätzliche Anfrage Produkte mit ähnlichen Mustern anzeigen lassen.

Die Möglichkeiten dürften im Laufe der Zeit stark ausgebaut werden und langsam wird deutlich, warum man Google Lens derzeit mit der Brechstange in das Blickfeld der Nutzer bringen möchte. Es ist eine wichtige neue Anlaufstelle für die Google-Suche und natürlich verdient man schon heute mit der Vermittlung von Produkten an den Provisionen. Aus Nutzersicht kann das von Vorteil sein und vielleicht wird die Lens-Funktionalität langfristig in die Google Websuche oder in die Google-App integriert.

» Google Chrome & Google Drive: Vorschläge aus dem Cloudspeicher kommen auf die Neuer Tab-Seite

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter