Google Kamera: Riesiger Aufwand – so funktioniert das neue Portrait Light-Feature auf den Pixel-Smartphones

Google hat allen Besitzern eines neuen Pixel-Smartphones die Portrait Light Funktion spendiert, die als Bestandteil von Google Fotos die Beleuchtung aller Portrait-Bilder nachträglich ändern kann. Das Feature hat bei der Vorstellung für viel Begeisterung gesorgt und erschafft in den allermeisten Fällen nahezu in Echtzeit beeindruckende Bilder. Jetzt haben die Entwickler verraten, wie das Ganze funktioniert und welchen Aufwand sie vorab betrieben haben.

Jede neue Pixel-Generation bringt neue Kameratricks mit, das galt natürlich auch für die vor wenigen Monaten vorgestellte fünfte Generation sowie das Pixel 4a. Das beeindruckendste Feature greift allerdings nicht bei der Fotografie, sondern erst bei der Nachbearbeitung und kommt als Pixel-exklusives Feature bei Google Fotos. Dieses steht aber auch den Nutzern der zweiten, dritten und vierten Pixel-Generation zur Verfügung und lässt sich auch mit allen Portrait Fotos verwenden, die mit anderen Geräten aufgenommen wurden.

Portrait Light ermöglicht es, die Lichtquelle des Bildes nachträglich zu verändern – und zwar völlig frei. Einfach die neue Bearbeitungsmöglichkeit bei Google Fotos aufrufen, die Lichtquelle auf dem Bild platzieren und schon ändert sich die Ansicht. Dabei wird aber nicht nur ein heller Lichtkegel auf das Bild gelegt, sondern auch die Schattierungen und Tiefen werden automatisiert soweit angepasst, dass es in nahezu jedem Fall realistisch aussieht. Natürlich mag es Ausnahmen geben, aber grundsätzlich funktioniert das nahezu in Echtzeit.

Das Ganze funktioniert, wie bei allen Features der Fotografie üblich, mit Künstlicher Intelligenz, massenhaft gesammelten Daten sowie heruntergerechneten Modellen, die lokal auf dem Smartphone zum Einsatz kommen. Und so ist es Google gelungen, mit massivem Aufwand ein KI-Modell zu schaffen, das weniger als 10 MB auf dem Smartphone einnimmt und diesen Effekt ermöglicht.

Pixel 5: Google Wallpapers bringt neuen Conveyor Belt Live Wallpaper mit 3D-Objekten & Statusinformationen

Künstliche Intelligenz basiert auf massenhaft Daten, in denen Muster erkannt und dann auf andere Fälle angewendet werden – stark vereinfacht gesagt. Also benötigte Google zur Umsetzung dieses Features eine große Datenbank an Bilddaten mit den unterschiedlichsten Beleuchtungen, Beleuchtungswinkeln und Aufnahmewinkeln, um den Schattenverlauf und die Auswirkungen auf Tiefen, Hautfarben und Objekte auszuwerten. Und dafür hat man obigen Versuchsaufbau verwendet.

Das Team hat einen großen Aufbau mit 331 LED-Lichtquellen sowie 64 jeweils leicht versetzt positionierte Kameras verwendet. Dadurch lassen sich von jedem Motiv in Kombination unzählige Kombinationen aufnehmen. Nach meinen bescheidenen Mathematik-Kenntnissen wären das allein bei Verwendung jeweils einer einzelnen LED mehr als 21.000 Bilder. Sicherlich hat man aber auch mal mehrere LEDs zusammengeschaltet. In diesen Aufbau hat man dann 70 Personen gesetzt, die dafür abgelichtet wurden. Und damit sind wir dann schon bei knapp 1,5 Millionen Fotos.

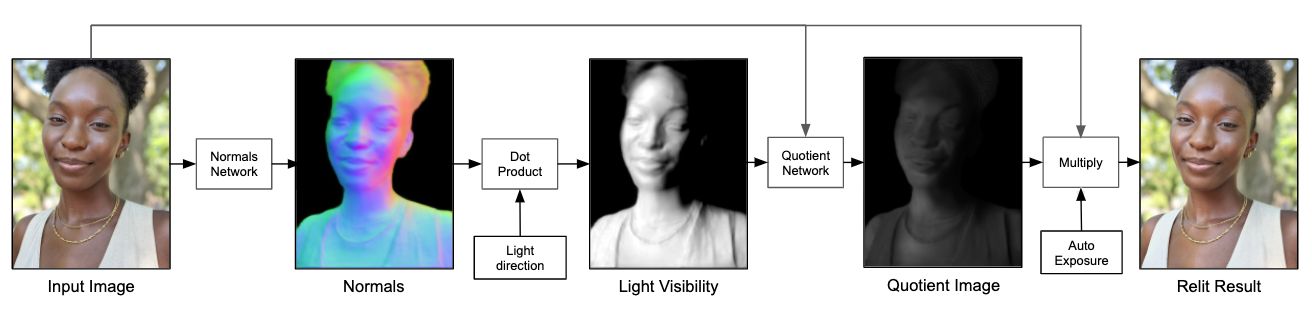

The pipeline of our relighting network. Given an input portrait, we estimate per-pixel surface normals, which we then use to compute a light visibility map. The model is trained to produce a low-resolution quotient image that, when upsampled and applied as a multiplier to the original image, produces the original portrait with an extra light source added synthetically into the scene.

Aus diesen Daten hat man dann die Lichtquellen berechnet und konnte die Auswirkungen sehr genau beobachten. Jede Tiefe, jede Hautfalte, Hautfarbe, Hintergründe, Materialien und vieles mehr konnten dadurch ausgewertet werden. Oben seht ihr im Diagramm und der Erklärung, wie diese Veränderungen in einzelne Kanäle aufgeteilt wurden. Das sind schon beeindruckende Effekte, aber viel beeindruckender finde ich fast schon, dass man die Erkenntnisse in nur 10 MB stopfen konnte.

Im Folgenden noch einige Beispiel-Animationen, die den Portrait Light-Modus verdeutlichen. Auf der anderen Seite hat Google übrigens dafür gesorgt, dass die Portrait Modus-Originale nur noch schwer zugänglich sind – vielleicht werden auch diese in Zukunft automatisiert zurückberechnet. Wie ihr die Originale dennoch wiederherstellen könnt, erfahrt ihr in diesem Artikel.

Pixel 5: Google Wallpapers bringt neuen Conveyor Belt Live Wallpaper mit 3D-Objekten & Statusinformationen

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Und was soll das dann bringen? Ist doch eigentlich egal woher die Lichtquelle kommt, oder?