Pixel 4: Interessante Einblicke – so funktioniert der Radarchip Soli & das ’sieht‘ Googles Motion Sense

Mit den Pixel 4-Smartphones hat Google das Motion Sense-Feature eingeführt, mit dem sich das Smartphone zum Teil mit Gesten und ohne jegliche Berührung steuern lässt. Dazu kommt eine von Google seit langer Zeit entwickelte Radar-Technologie zum Einsatz, in die man nun sehr interessante Einblicke gibt. Erstmals haben Googles Forscher nun Bilder veröffentlicht, die sehr genau zeigen, was der Radarchip „sehen“ kann. Und das ist nicht viel.

Wir berichten schon seit einigen Jahren vom Project Soli und haben das von Google aus der Taufe gehobene Radarprojekt schon seit den Anfängen begleitet, natürlich ohne damals zu wissen, wofür es eines Tages eingesetzt werden könnte. Mittlerweile ist der entwickelte Radarchip in den aktuellen Pixel-Smartphones zu finden und kann dort erstmals präsentieren, was mit der neuen Technologie möglich ist.

Die Notwendigkeit der Motion Sense-Technologie in den Pixel 4-Smartphones kann durchaus hinterfragt werden, denn bis auf einige Spielereien lassen sich kaum sinnvolle Funktionen steuern oder Dinge erledigen. Wer das Projekt schon seit längerer Zeit verfolgt und damit auch weiß, wozu das dahinter stehende Project Soli in der Lage ist, ist natürlich im ersten Moment enttäuscht. Mehr scheint derzeit aber auch wirklich nicht drin zu sein, wie die folgende von Google veröffentlichte Animation nun zeigt.

Links: Person läuft auf das Smartphone zu. Mitte: Die Person greift nach dem Smartphone. Rechts: Die Person swiped über das Smartphone.

Mit der Erklärung der einzelnen Animationen kann man das vielleicht noch nachvollziehen, aber ohne sieht es einfach nur nach Bildstörung mit merkwürdigen Mustern aus. Natürlich benötigen solche Technologien kein klares Bild, aber es zeigt, dass die Technologie noch ganz am Anfang steht und wohl sehr lange benötigen wird, um deutlich feinere Bewegungen zu bemerken, korrekt auszuwerten und die entsprechenden Schritte einzuleiten.

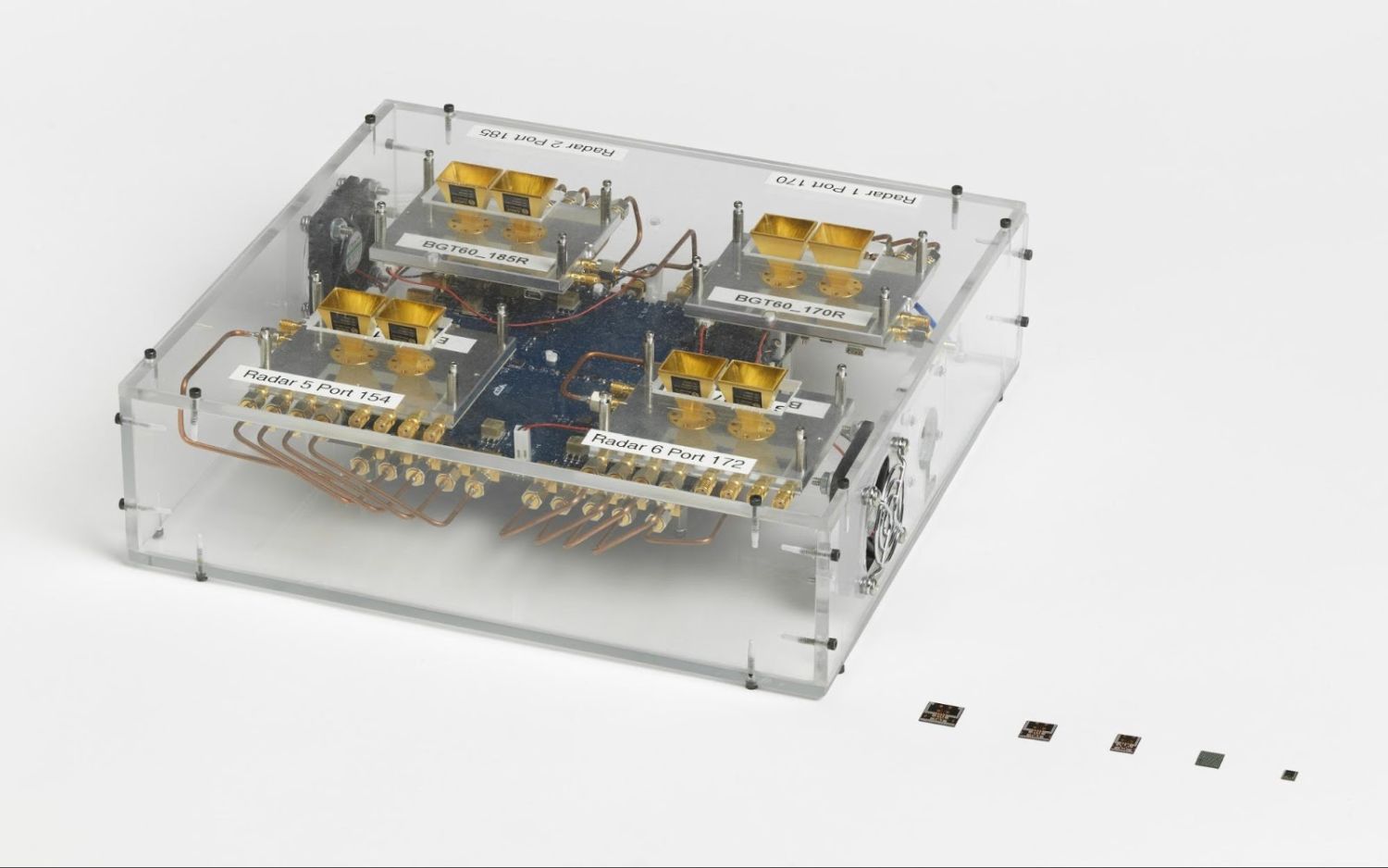

In früheren Technologie-Demos hatte das Project Soli sehr viel mehr Möglichkeiten und konnte auch die Bewegung einzelner Finger erkennen oder Formen sehr gut erkennen. Allerdings kam damals ein deutlich größeres Gerät zum Einsatz – zum Teil so groß wie ein Desktop-Computer (siehe obiges Foto). Jetzt ist der Chip auf eine Größe von 5×6 Millimeter verkleinert worden, damit er in das Smartphone integriert werden konnte. Dadurch verringert sich natürlich auch der Grad der Erkennung ganz erheblich.

Derzeit sieht es so aus, dass Google das Soli-Projekt für die Pixel-Smartphones ruhen lässt und weder bei den Pixel 4a noch bei den Pixel 5 einsetzen wird. Vielleicht auch eine ganz gute Idee, bis das Projekt weiter fortschreitet und mehr Möglichkeiten bieten kann – wofür aber vermutlich auch die Erkennung deutlich verbessert werden muss. Zwischen den Zeilen der Ankündigung geht hervor, dass man es bei den Pixel 4-Smartphones als Experiment betrachtet hat. Es war halt Platz über dem Display.

Im Google AI-Blog gibt es für technisch interessierte sehr viele weitere Einblicke und Beschreibungen über die Funktionsweise von Soli. Für einige sicher sehr interessant.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Schade das Google dafür keine API anbietet, so das Entwickler es in ihre Programme nutzen könnten.