Google Maps: Integration von Google Lens ist endlich da – die Augen des Assistant helfen nun im Restaurant

Google Maps enthält unglaublich viele Informationen zu nahezu jedem Ort dieser Welt, sowohl in Text- als auch in Bildform. Aber Maps soll nicht nur Informationen bereithalten, sondern diese auch zum passenden Zeitpunkt anbieten. Jetzt wird die schon vor längerer Zeit angekündigte Integration von Google Lens in Google Maps ausgerollt, die im ersten Schritt die Auswahl im Restaurant erleichtern soll. Die Augen des Google Assistant wereden damit auch zum Speisekarten-Assistenten.

Google Maps Streetview: Mit diesen Fahrzeugen ist das Streetview-Team rund um die Welt unterwegs (Galerie)

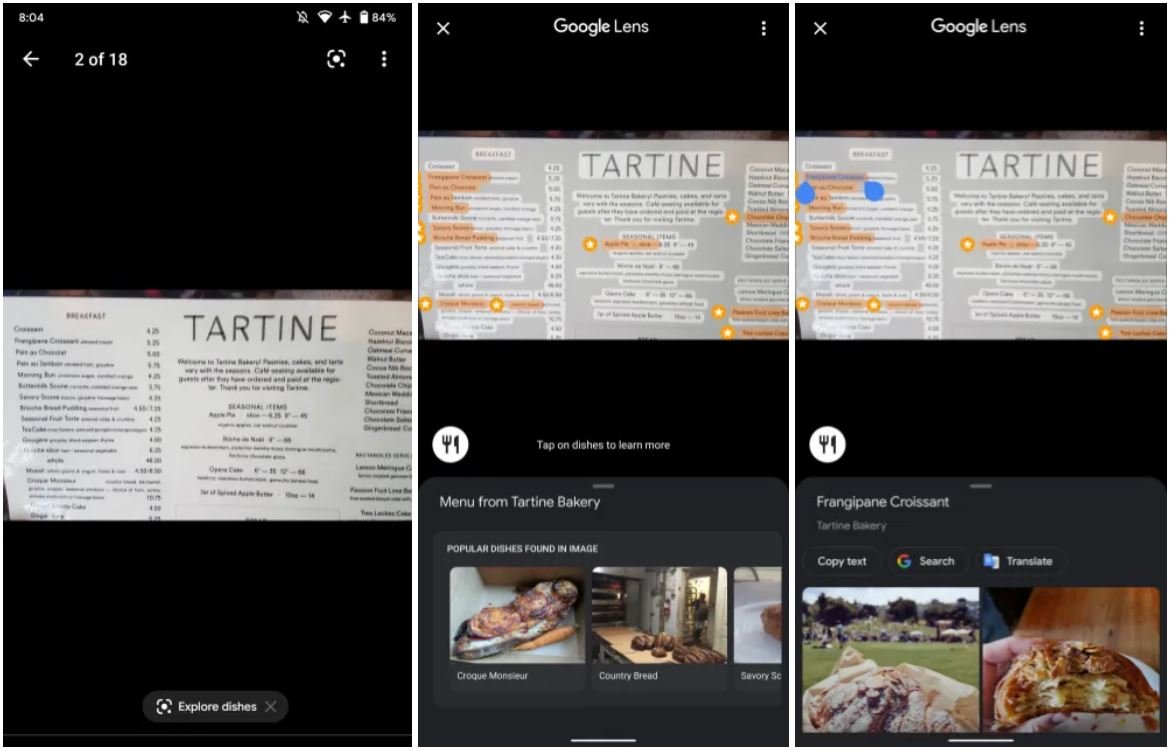

Wer kennt das nicht? Man kommt in ein Restaurant, wird von der langen Speisekarte förmlich erschlagen und hat keine Ahnung, was man essen soll. Damit man am Ende nicht immer wieder die gleichen Grundgerichte, die es in fast jedem Restaurant gibt, nimmt, können nun auch Googles Tools behilflich sein. Im Zusammenspiel von Lens und Maps ist es möglich, sich einzelne Gerichte von der Speisekarte hervorheben und empfehlen zu lassen.

Das Ganze funktioniert direkt über Google Lens: Startet die Kamera und haltet sie einfach auf die Speisekarte und der Rest geschieht dann automatisch. Wie ihr auf obiger Animation sehen könnt, markiert Lens einige Gerichte auf der Speisekarte mit einem Stern und hält zu diesen weitere Informationen und Fotos bereit. Die Fotos stammen natürlich von den zahlreichen Nutzern von Google Maps, sodass sie eher der Wahrheit entsprechen als die schönen Bilder auf der Speisekarte oder am Eingang des Restaurants.

Google hat diese Funktion bereits vor einigen Monaten erstmals angekündigt, aber niemals den offiziellen Startschuss gegeben. Weil es nun aber bei immer mehr Nutzern in der Android-App auftaucht und abermals zwischen den Zeilen angekündigt wurde, kann man davon ausgehen, dass die Funktion mittlerweile verfügbar ist. Weil das dafür notwendige Datenmaterial, Google Maps und auch Google Lens in deutscher Sprache zur Verfügung stehen, sollte es weltweit ausgerollt werden – allerdings nur für Android-Nutzer. Unter iOS ist es nicht verfügbar.

Wer also in den nächsten Tagen ein Restaurant aufsucht, kann diese Funktion einfach mal ausprobieren. Auch wenn das Ergebnis sehr einfach ist und das Angebot sehr simpel aussieht, kommt im Hintergrund doch eine sehr beeindruckende Technologie zum Einsatz, die endlich in die Richtung geht, die Google schon vor über zwei Jahren für Lens versprochen hat. Um das zu erfassen, müssen wir einfach nur mal überlegen, wie viele Daten abgefragt und miteinander kombiniert werden müssen, um dies zu ermöglichen:

Google Lens muss den Standort des Nutzers kennen und mit Google Maps abgleichen, um zu wissen, in welchem Restaurant der Nutzer ist. Danach muss das Layout der Speisekarte erfasst, der Text erkannt und die Namen der Gerichte zugeordnet werden. Diese Zuordnung wird dann wieder mit Google Maps abgeglichen, die besten Gerichte herausgesucht und anschließend der Text im Livebild virtuell markiert. Das alles geschieht praktisch Live – schon sehr beeindruckend.

Google Maps Streetview: Mit diesen Fahrzeugen ist das Streetview-Team rund um die Welt unterwegs (Galerie)

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter