Project Soli: Googles neue Eingabemethode mit Radar-Technologie macht große Fortschritte (Video)

Vor mittlerweile über dreieinhalb Jahren hat Google das Project Soli vorgestellt, das es sich zum Ziel gesetzt hat, die Hände und Finger des Menschen als Eingabemethode zu verwenden – ganz ohne jede Berührung. Dazu kommt eine Radartechnologie zum Einsatz, für dessen Anwendung Google erst jetzt die Freigabe von der amerikanischen FCC erhalten hat. Das könnte zukünftig viele interessante neue Geräte und Eingabemethoden ermöglichen.

Es gibt viele verschiedene Möglichkeiten, um mit einem Gerät zu interagieren. Am Computer ist es die Tastatur sowie die Maus bzw. das Touchpad, auf dem Smartphone ist es das Touch-Display und das Mikrofon. Auch wenn einiges davon erst in den letzten Jahren perfektioniert wurde, haben die Technologien und Methoden schon sehr viele Jahre auf dem Buckel. Google möchte nun bald eine Eingabemethode auf den Markt bringen, die einen völlig anderen Ansatz wählt.

Mit dem Project Soli soll es möglich sein, dass der Nutzer durch simple Gesten mit der Hand oder den Fingern ein Gerät bedient, ohne dass dieses an irgendeiner Stelle berührt werden muss. Solche Möglichkeiten setzen bisher auf Kameras und Bewegungserkennungen, wobei Microsofts Kinect eine sehr populäre Lösung gewesen ist. Googles Project Soli hingegen setzt auf Radar und kommt so vollständig ohne Kamera aus, womit auch die Benutzung leichter wird, da man sich nicht künstlich vor der Kamera bewegen muss.

Google hat nun die Zulassung von der FCC erhalten, höhere Frequenzbänder für dieses Radar nutzen zu können, um die Genauigkeit der Erkennung zu erhöhen. Diese Zulassung dürfte dafür gesorgt haben, dass sich das Projekt um mehrere Jahre verzögert hat – aber nun kann es weitergehen bzw. praktische Anwendungsmöglichkeiten geschaffen werden. Soli benötigt für seine Aufgabe nur einen winzigen Chip, der nicht größer als ein kleiner Fingernagel ist. Dadurch ist er auch in mobilen Geräten wie Smartphones oder Smartwatches einsetzbar.

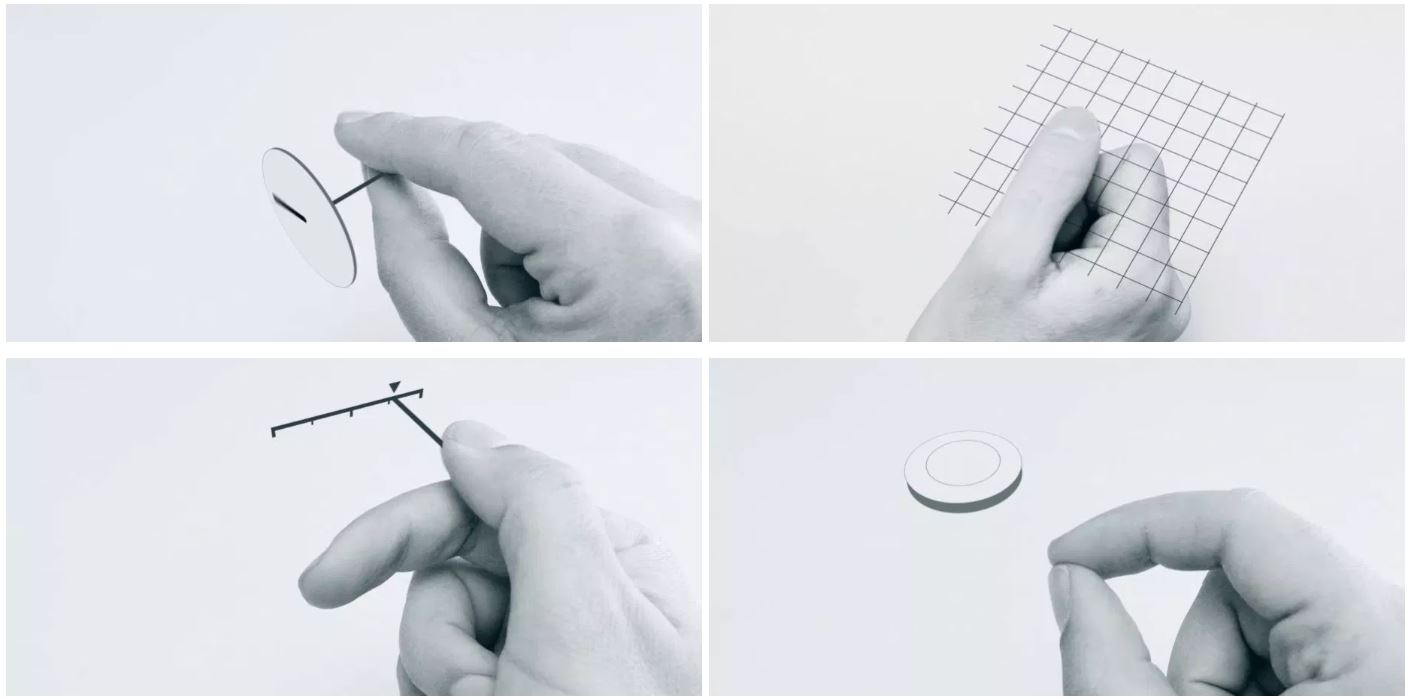

In obigem Video wird die Technologie hinter Soli sowie mögliche Anwendungsgebiete gezeigt. Wie man sieht, können ganz klassische Bewegungen wie das Drehen an Lautstärkereglern, das Drücken auf Knöpfe oder sogar das Scrollen auf Touch-Oberflächen vollständig ohne jegliche Oberfläche simuliert werden. Dadurch sollte es etwa möglich sein, das kleine Smartwatch-Display nicht nur mit den Fingerspitzen, sondern auch auf großer Fläche zu bedienen.

Wenn diese Technik erst einmal marktreif ist, ergeben sich dadurch viele weitere spannende Möglichkeiten. Insbesondere für das Internet of Things könnte es interessant werden, denn viele Geräte verfügen über kein Display oder Touchscreen, könnten so aber dennoch bedient werden. In Kombination mit den faltbaren Displays wird das noch spannender, denn so ließen sich auch auf kleinen Displays große Eingaben durchführen.

Auch im Bereich der Augmented Reality könnte das sehr spannend werden, wenn man plötzlich Dinge und Geräte bedienen kann, die eigentlich gar nicht da sind.

» Alle Artikel rund um das Project Soli

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter