Google Lens: Rollout auf die Pixel-Smartphones beginnt – so lässt er sich auf anderen Smartphones nutzen

Google Lens ist zwar ein eigenständiges Paket, gilt aber als Erweiterung für den Assistant und bringt diesem das Erkennen und Analysieren von Bildern und Fotos aller Art bei. Bisher stand Lens aber nur sehr eingeschränkt über die Photos-App zur Verfügung und war ausgerechnet im Assistenten nicht zu finden. Das wird sich für die Besitzer eines Pixel-Smartphones nun ändern, denn bei den ersten ist Lens bereits angekommen.

Es ist nun schon genau ein halbes Jahr her, dass Google erstmals Lens vorgestellt hat und auf der Bühne verkündete, dass der Assistant neben der Erkennung von Textbefehlen und Sprache auch einen dritten Sinn bekommen wird. Am 4. Oktober wurde Lens dann erneut als Pixel-exklusives Produkt vorgestellt, doch insgesamt ist es noch sehr ruhig um den Assistenten. Jetzt dürfte er endlich seinen großen Auftritt bekommen.

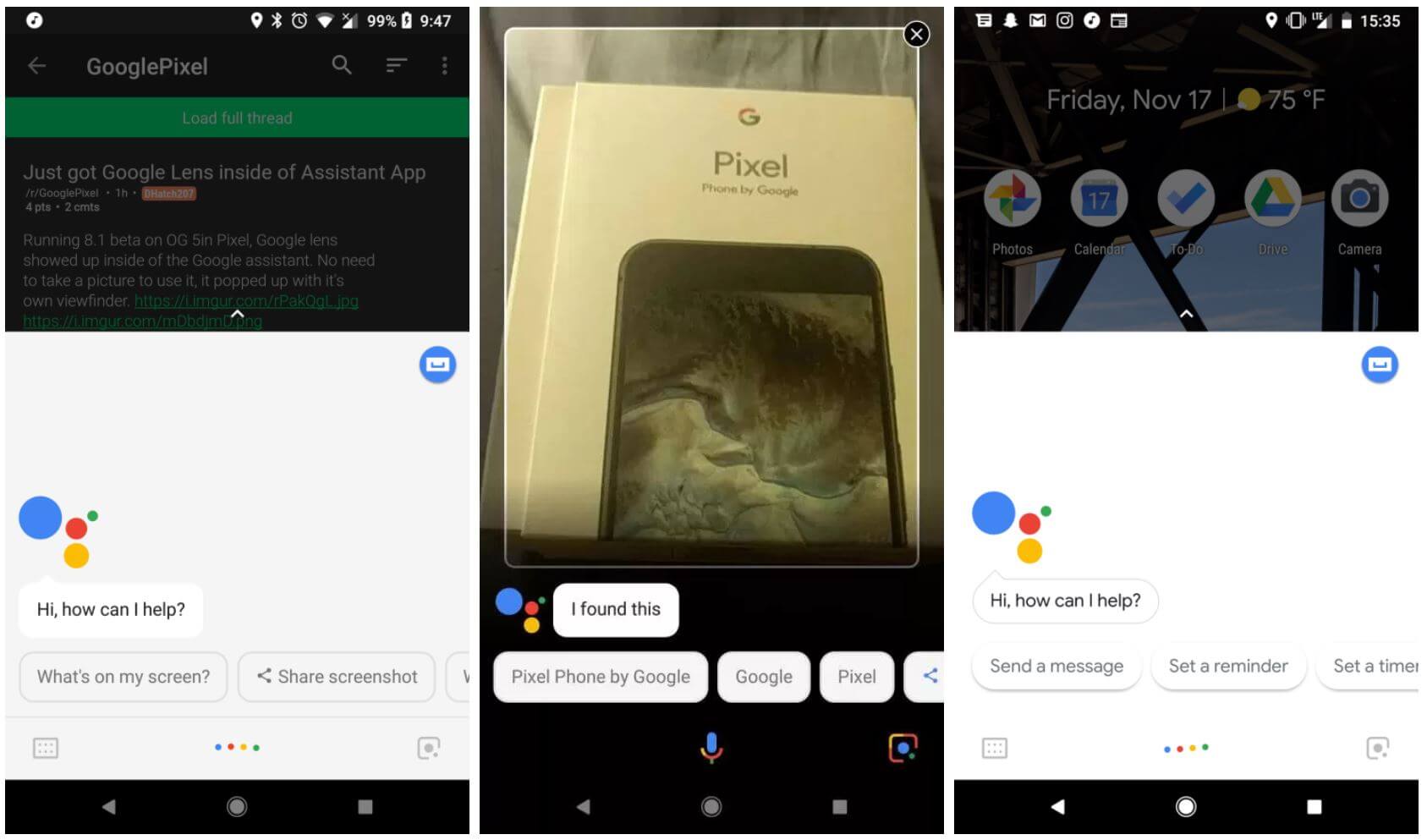

Bisher stand der Google Assistant nur in der Photos-App zur Verfügung und konnte nur Fotos aus der App analysieren. Wie ihr den Assistenten in Photos aktivieren könnt, seht ihr weiter unten im Artikel. Schon vor einigen Woche hatte eine Google-Managerin angekündigt, dass Lens schon bald in den Assistant integriert wird – und jetzt ist es soweit. Die ersten Nutzer haben Lens bereits bekommen und können das Tool nun auch direkt mit der Kamera nutzen.

Das Lens-Icon ist relativ unscheinbar, befindet sich aber an erwartete Steller unten rechts in der App. Links ist der Button für die Tastatur-Eingabe, in der Mitte der Button für die Sprache und Rechts eben nun der Button für die Augen. Mit einem Touch auf den Button öffnet sich direkt die Kamera, die direkt auf ein zu analysierendes Objekt gehalten werden kann. Mit einem weiteren Touch wird das Bild eingefroren und anschließend analysiert. Dabei kommt eine sehenswerte Animation zum Einsatz.

Hat Lens dann etwas erkannt, werden die Informationen direkt unter dem Bild dargestellt, so wie es auf folgenden Screenshots sehr gut zu sehen ist.

Eine Live-Analyse gibt es leider noch nicht, so wie man sie etwa von Google Translate kennt, denn dafür müssten wohl doch zu viele Daten hin und her-gesendet werden. Ausgeschlossen ist eine solche Funktion aber nicht, da selbst das ehrwürdige Google Goggles schon zu einigen Bereiche eine Live-Analyse angeboten hat – und das vor fast 7 Jahren.

Offiziell wurde der Rollout von Lens für den Assistenten noch nicht angekündigt, aber da es die ersten Nutzer bereits bekommen haben, und die Plattform ohnehin schon seit Wochen zur Verfügung steht, ist es wohl nur noch eine Frage von Tagen bis auch alle anderen Nutzer den Assistenten bekommen. Vorerst wird er nur auf die Pixel und Pixel 2-Smartphones ausgerollt und dürfte diese Exklusivität wohl für einige Monate behalten, so wie man es damals auch vom Assistenten kannte.

Lens steht nach dem Rollout zusätzlich im Assistant zur Verfügung, ersetzt aber nicht die „Was ist auf meinem Bildschirm?“-Funktion, die auch weiterhin zur Verfügung steht. Eines greift eben auf den Screenshot und anderen auf die Kamera zu. Eine Verschmelzung beider Funktionen ist in Zukunft aber möglich und wäre auch sinnvoll.

Wenn ihr euch einen Überblick über die Möglichkeiten von Lens verschaffen möchtet, die der Assistent einmal haben wird, empfehle ich dieses Video. Leider funktioniert das in der Form noch nicht, aber es zeigt ein mögliches Einsatzgebiet des visuellen Assistenten.

So lässt sich Google Lens in Photos schon jetzt aktivieren

Voraussetzung für diese Schritte ist ein gerootetes Smartphone, denn wir müssen der Photos-App vorspielen, ein Pixel-Smartphone zu besitzen. In der Assistant-App funktioniert das noch nicht, aber nach dem Rollout ist es gut möglich, dass er überraschend dann auch an dieser Stelle zur Verfügung stehen wird. Einfach Daumen drücken.

Die einzelnen Schritte

- 1. Euer Smartphone muss gerootet sein

- 2. Ladet diese ZIP-Datei herunter. Sie enthält die beiden zu bearbeitenden Dateien

- 3. Startet das Smartphone in den TWRP-Recovery-Modus zum flashen der ZIP-Datei

- 4. Jetzt die ZIP-Datei flashen

- 5. Startet das Smartphone neu und öffnet anschließend Google Photos

Der Assistent setzt sich direkt auf den Info-Button jedes Fotos und versucht die Inhalte zu erkennen. Das liefert wie bereits gesagt noch keine ganz so beeindruckenden Ergebnisse, befindet sich aber auch erst in der Test-Phase mit eingeschränktem Funktionsumfang. Ist Lens erst einmal aktiviert, wird es dauerhaft zur Verfügung stehen und die Erkennung aller Bilder anbieten.

» Weitere Informationen zur Lens-Aktivierung

Siehe auch

» Alles aus Google Photos herausholen: So lässt sich die Gesichtserkennung und Google Lens aktivieren

» Google Photos: Wirklich sehenswert – Google Lens hat eine neue Lade-Animation (Video)

» Alle Informationen rund um Google Lens

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter