Webmaster Tools mit verbesserter robots.txt-Analyse

Ein falscher oder fehlerhafter Eintrag in der robots.txt-Datei kann nicht nur ärgerlich sein, sondern unter Umständen auch die ganze Webpräsenz gefährden. Durch einen kleinen falschen Eintrag, kann man alle Suchmaschinen vom parsen ausschließen und schon sind die Besucherströme dahin. Um solchen Dinge vorzubeugen, hat Google den robots.txt-Parser der Webmaster Tools stark ausgebaut und verbessert.

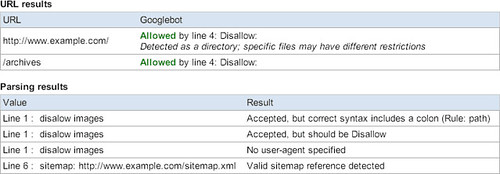

Die Analyse der robots.txt zeigt jetzt nicht mehr nur die eigentliche Einträge an, sondern gibt auch Vorschläge und Hinweise über eventuell nicht beabsichtigte Dinge. Ein „Disalow“ statt „Disallow“ wird von Google akzeptiert, von anderen Suchmaschinen aber eventuell nicht – daher sollte man diesen Fehler ausbessern. Auch der fehlende Slash vor dem Verzeichnisnamen sollte dann – auf Vorschlag – dringenst nachgebessert werden.

So langsam werden die Webmaster Tools wirklich unverzichtbar, vorallem bei der Einrichtung einer neuen Webpräsenz und deren anfänglicher Testphase. Ich persönlich brauche aber zumindest diesen Test nicht, da sich meine robots.txt lediglich auf den Aufenthaltsort der Sitemaps-Datei beschränkt

» Ankündigung im Webmaster-Blog

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Deshalb besonderen Dank!

Schaue ich mir sofort an. Meine Besucherzahlen gehen gerade mal wieder runter und ich finde keinen Grund warum

macdet

— hartz iv muss man sich leisten können —

Hallo

Ansich ja eine gute Sache. Wenn man aber, so wie ich, über die robots.txt einige schädliche BOTs versucht auszusperren, kann die Datei schnell zu lang werden. Eine Analyse ist dann nicht mehr möglich da die max. Anzahl an Zeichen überschritten wird.

Hier kann man ja Super Tips und Tricks finden!

Danke MfG Sky